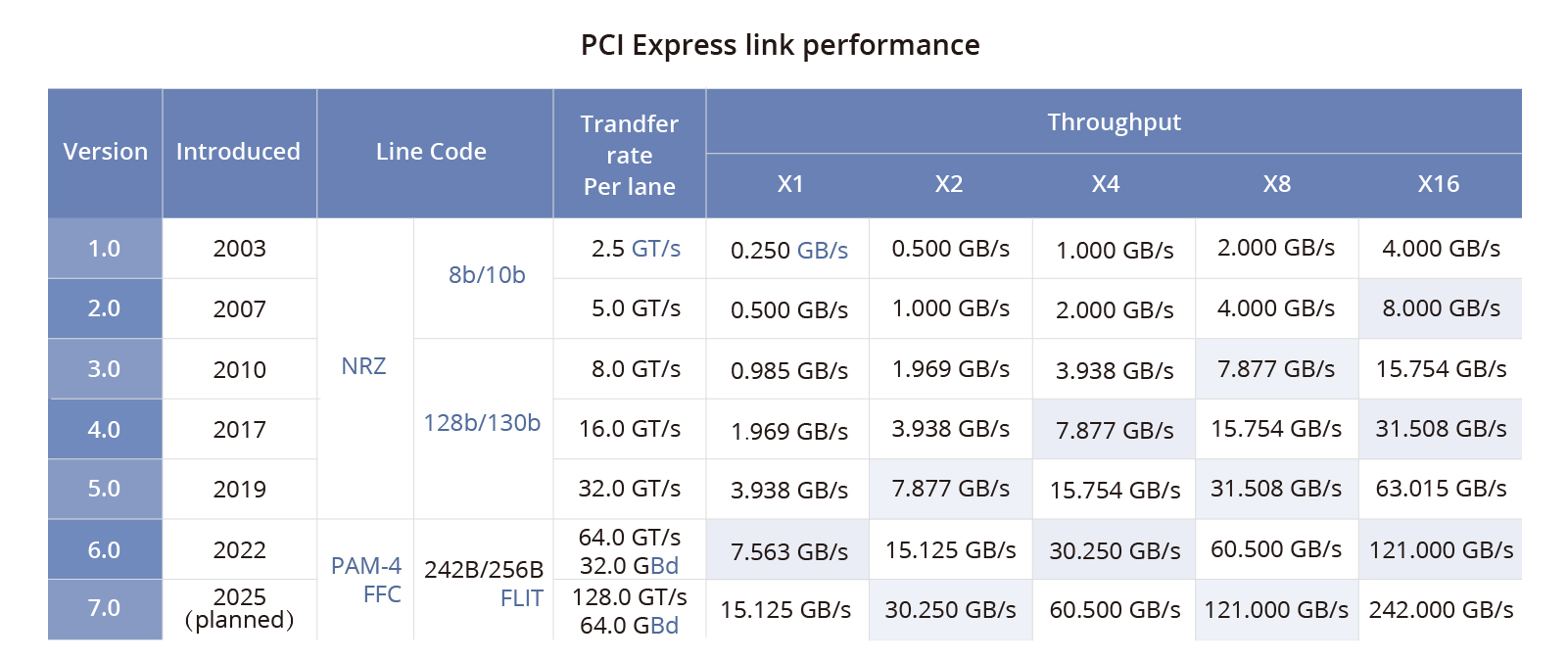

传统的PCIe接口在数据传输速率上存在限制,而NVLink通过专用的高速通道,使得GPU之间的数据交换更加高效。例如,第四代NVLink的带宽高达112Gbps,是PCIe Gen5的三倍,显著提升了数据处理能力。这种高速互联技术在科学计算、大数据处理等领域尤为重要。

NVSwitch芯片作为NVLink技术的核心组件,能够连接多个GPU,形成一个高效的网络架构。第三代NVSwitch支持高达900 GB/s的互连速率,使得大规模GPU集群的协同工作成为可能。这种技术不仅在提升计算性能上效果显著,还通过集成SHARP功能,优化了计算资源的利用率。

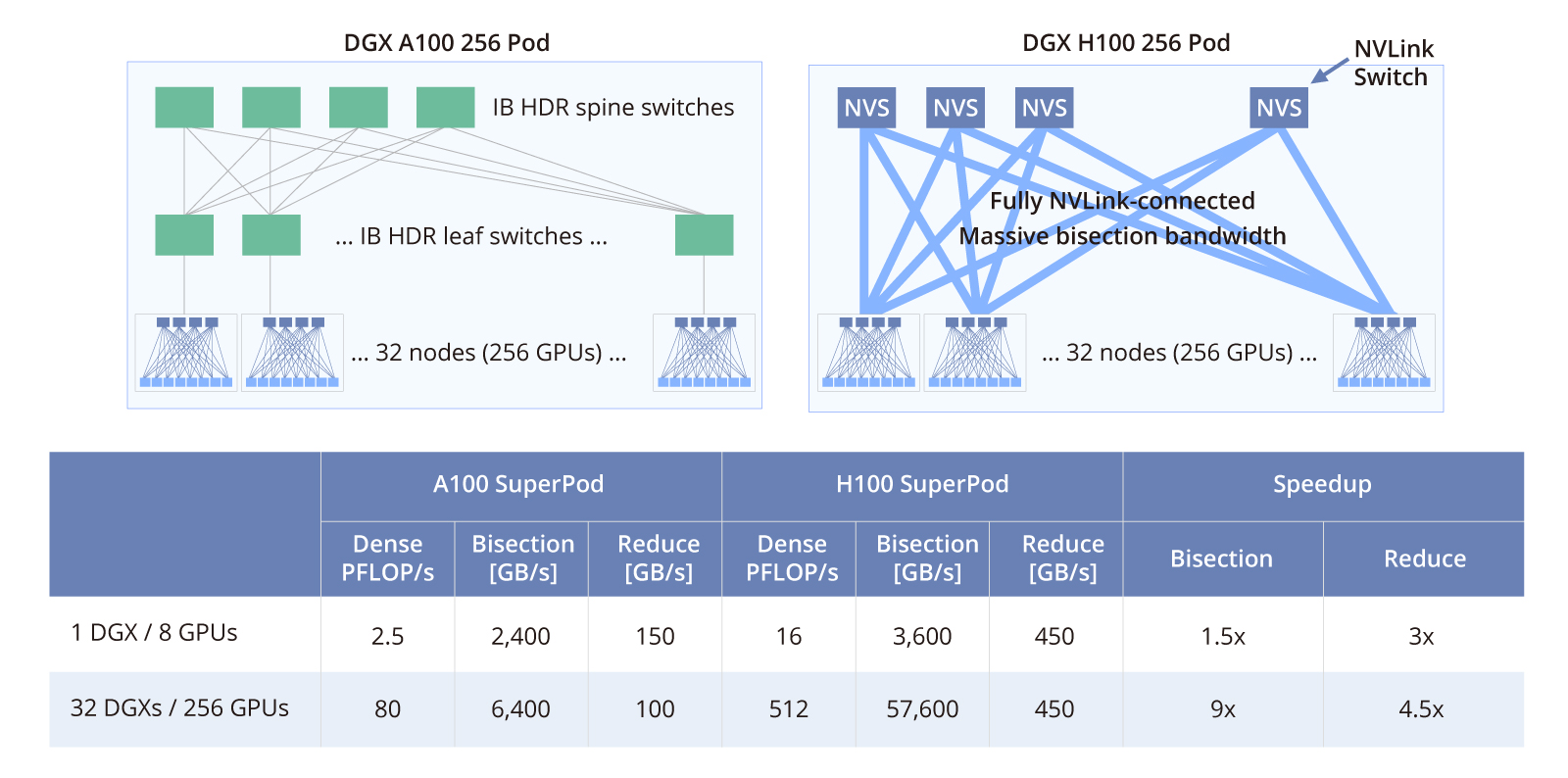

在服务器应用方面,NVLink技术被广泛应用于英伟达的DGX系列服务器中。这些服务器通过NVLink和NVSwitch技术,实现了卓越的GPU互联性,提供了强大的计算能力和高效的数据处理能力。例如,第四代DGX系统采用了最新的NVLink技术,成为高性能计算领域的标杆。

NVLink网络则进一步扩展了这一技术的应用范围,通过将多个NVLink服务器连接成一个大型Fabric网络,解决了大规模GPU集群的高速通信问题。每个服务器在NVLink网络中拥有独立的地址空间,确保了数据传输的安全性和隔离性。

与传统的InfiniBand网络相比,NVLink网络在GPU之间提供了更高的带宽和更低的延迟,特别适用于大规模GPU集群的应用场景。虽然InfiniBand网络在高性能计算中也有广泛应用,但NVLink网络在GPU特定应用中表现更为出色。

总之,NVIDIA NVLink技术通过其独特的高速互联架构,极大地提升了多GPU系统的性能,成为高性能计算领域不可或缺的关键技术。随着计算需求的不断增长,NVLink的重要性和影响力将持续扩大,推动技术创新和应用的深入发展。NVIDIA NVLink已成为高性能计算(HPC)领域的关键技术。本文深入探讨了NVLink的复杂性,并介绍NVSwitch芯片、NVLink服务器和NVLink交换机,以揭示其在不断演进的先进计算领域中的重要性。 什么是NVIDIA NVLink NVLink是一种解决服务器内GPU之间通信限制的协议。与传统的PCIe交换机不同,NVLink带宽有限,可以在服务器内的GPU之间实现高速直接互连。第四代NVLink提供更高的带宽,每条通道达到112Gbps,比PCIe Gen5通道速率快三倍。

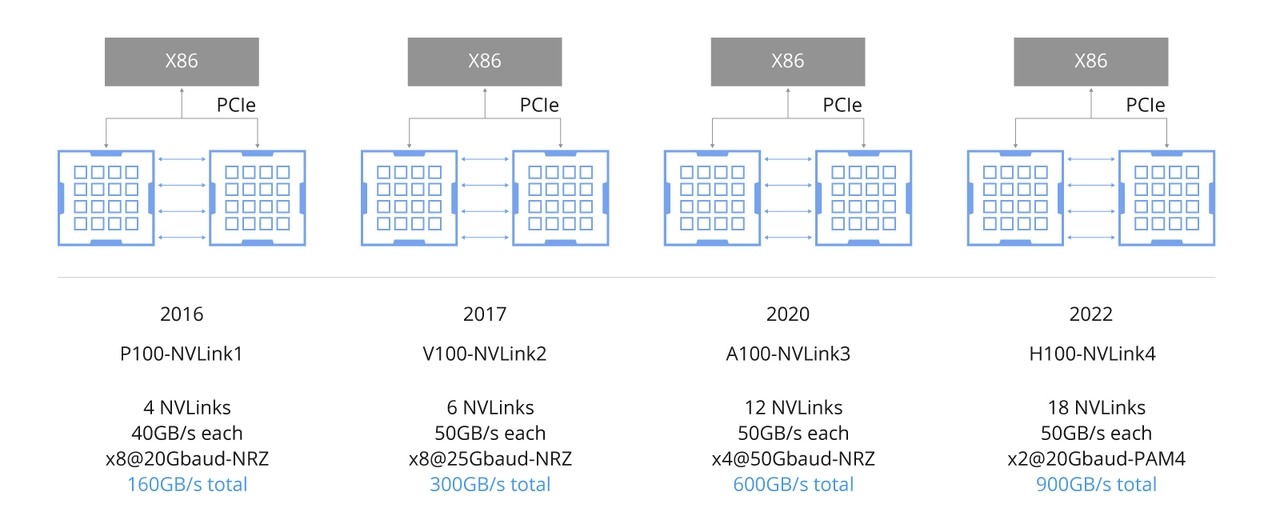

NVLink旨在为GPU直接互连提供简化、高速、点对点的网络,相比传统网络减少了开销。通过在不同层次提供CUDA加速,NVLink减少了与通信相关的网络开销。NVLink随着GPU架构的演进不断发展,从P100的NVLink1到H100的NVLink4,如图所示。NVLink 1.0、NVLink 2.0、NVLink 3.0和NVLink 4.0之间的关键区别在于连接方式、带宽和性能。

NVLink旨在为GPU直接互连提供简化、高速、点对点的网络,相比传统网络减少了开销。通过在不同层次提供CUDA加速,NVLink减少了与通信相关的网络开销。NVLink随着GPU架构的演进不断发展,从P100的NVLink1到H100的NVLink4,如图所示。NVLink 1.0、NVLink 2.0、NVLink 3.0和NVLink 4.0之间的关键区别在于连接方式、带宽和性能。

NVSwitch芯片

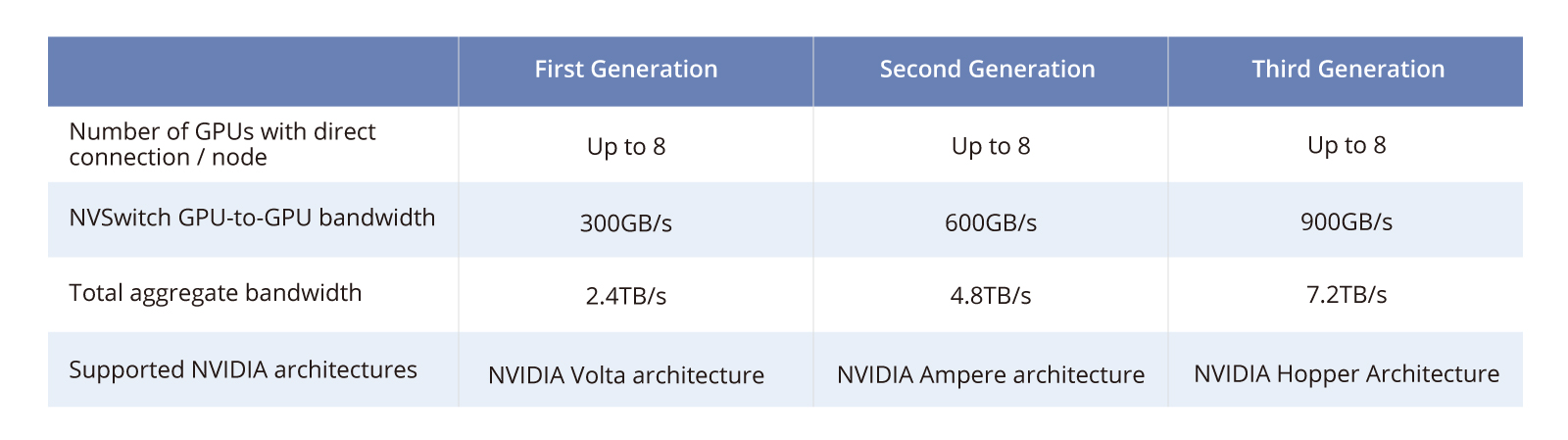

NVSwitch芯片是一种物理芯片,类似于交换机ASIC,可通过高速的NVLink接口连接多个GPU,提高服务器内的通信和带宽。第三代NVIDIA NVSwitch可支持以900 GB/s的速率互连每对GPU。

NVSwitch芯片

NVSwitch芯片是一种物理芯片,类似于交换机ASIC,可通过高速的NVLink接口连接多个GPU,提高服务器内的通信和带宽。第三代NVIDIA NVSwitch可支持以900 GB/s的速率互连每对GPU。

NVSwitch3芯片具有64个NVLink4端口,提供总共12.8 Tbps的单向带宽或3.2 TB/s的双向带宽。NVSwitch3芯片的独特之处在于其集成了SHARP功能,对多个GPU单元的计算结果进行聚合和更新,减少网络数据包并提高计算性能。

NVSwitch3芯片具有64个NVLink4端口,提供总共12.8 Tbps的单向带宽或3.2 TB/s的双向带宽。NVSwitch3芯片的独特之处在于其集成了SHARP功能,对多个GPU单元的计算结果进行聚合和更新,减少网络数据包并提高计算性能。

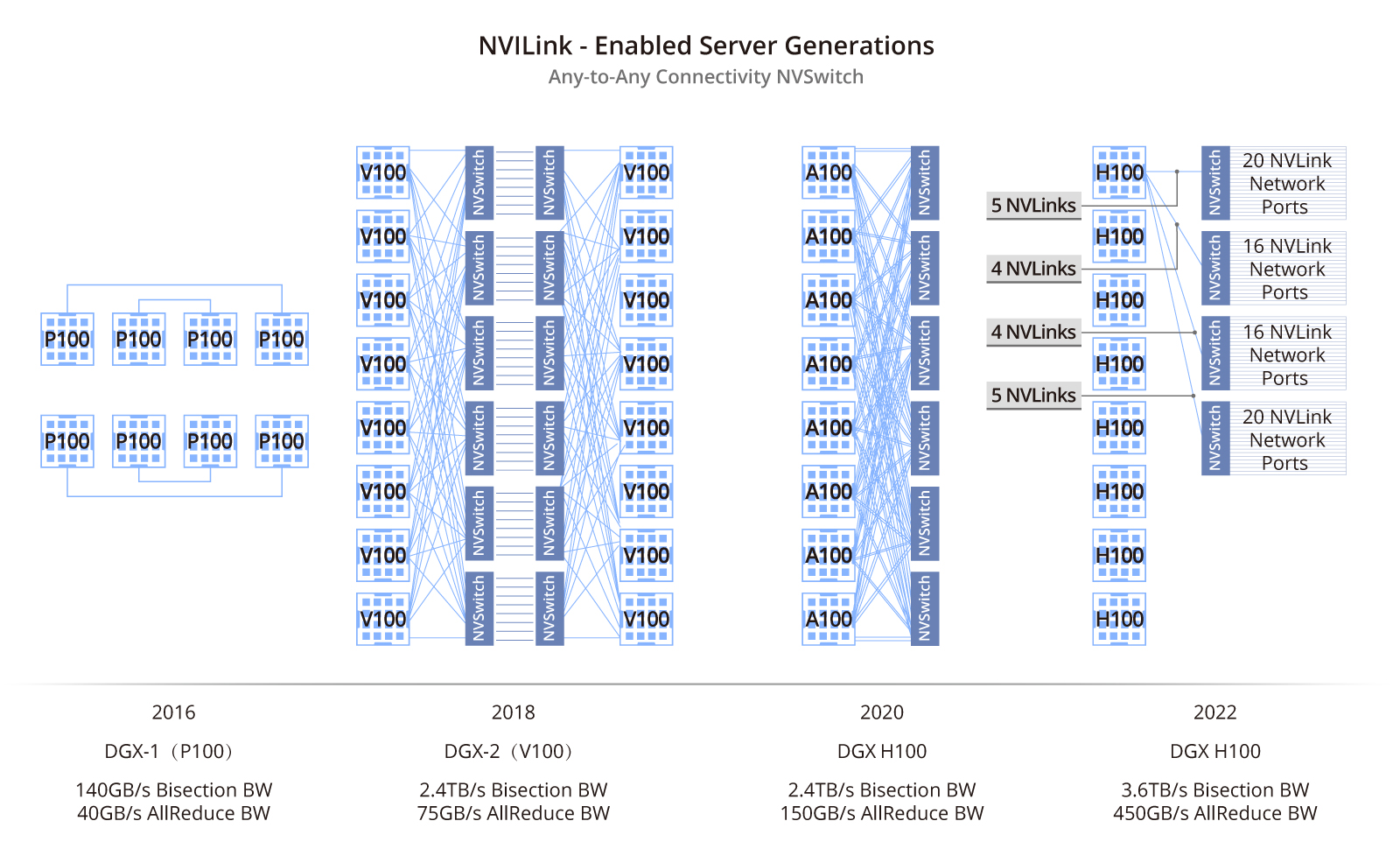

NVLink服务器

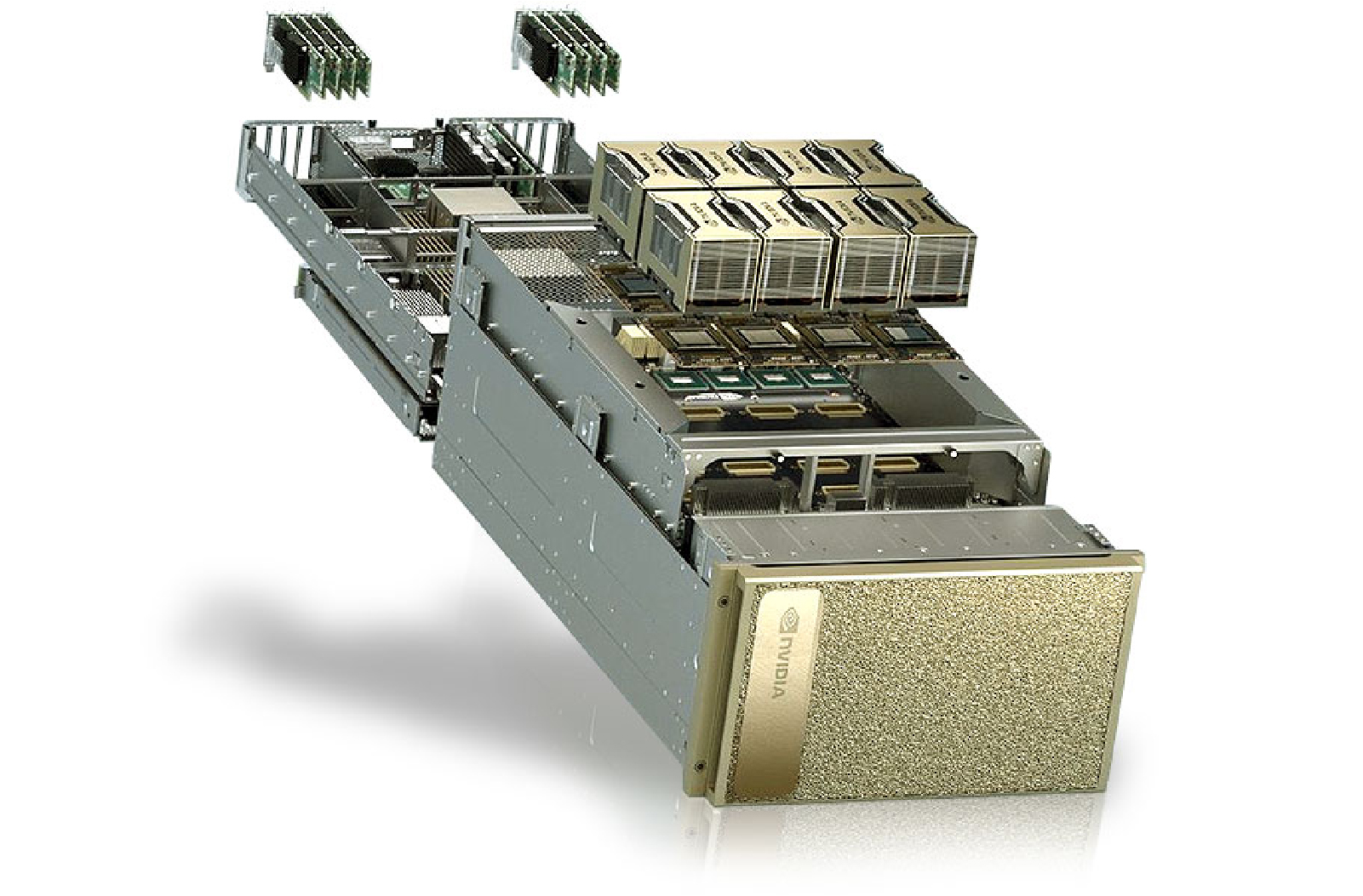

NVLink服务器采用NVLink和NVSwitch技术连接GPU,通常可在英伟达(NVIDIA)的DGX系列服务器或具有类似架构的OEM HGX服务器中找到。这些服务器利用NVLink技术,提供出色的GPU互联性、可扩展性和高性能计算能力。2022年,英伟达(NVIDIA)宣布推出第四代NVIDIA® DGX™系统,这是世界上首个采用新的NVIDIA DGX H100服务器构建平台。

NVLink服务器

NVLink服务器采用NVLink和NVSwitch技术连接GPU,通常可在英伟达(NVIDIA)的DGX系列服务器或具有类似架构的OEM HGX服务器中找到。这些服务器利用NVLink技术,提供出色的GPU互联性、可扩展性和高性能计算能力。2022年,英伟达(NVIDIA)宣布推出第四代NVIDIA® DGX™系统,这是世界上首个采用新的NVIDIA DGX H100服务器构建平台。

因此,NVLink服务器在科学计算、大数据处理和数据中心等关键领域已经变得不可或缺。通过提供强大的计算能力和高效的数据处理,NVLink服务器不仅满足了这些领域的严格要求,还推动了这些领域的进步和创新。

因此,NVLink服务器在科学计算、大数据处理和数据中心等关键领域已经变得不可或缺。通过提供强大的计算能力和高效的数据处理,NVLink服务器不仅满足了这些领域的严格要求,还推动了这些领域的进步和创新。

NVLink交换机

2022年,英伟达(NVIDIA)将NVSwitch芯片独立出来,并制作成NVLink交换机,用于连接主机之间的GPU设备。它采用了1U尺寸设计,具有32个OSFP端口;每个OSFP端口包含8个112G PAM4通道,每个交换机内置2个NVSwitch3芯片。

NVLink交换机

2022年,英伟达(NVIDIA)将NVSwitch芯片独立出来,并制作成NVLink交换机,用于连接主机之间的GPU设备。它采用了1U尺寸设计,具有32个OSFP端口;每个OSFP端口包含8个112G PAM4通道,每个交换机内置2个NVSwitch3芯片。

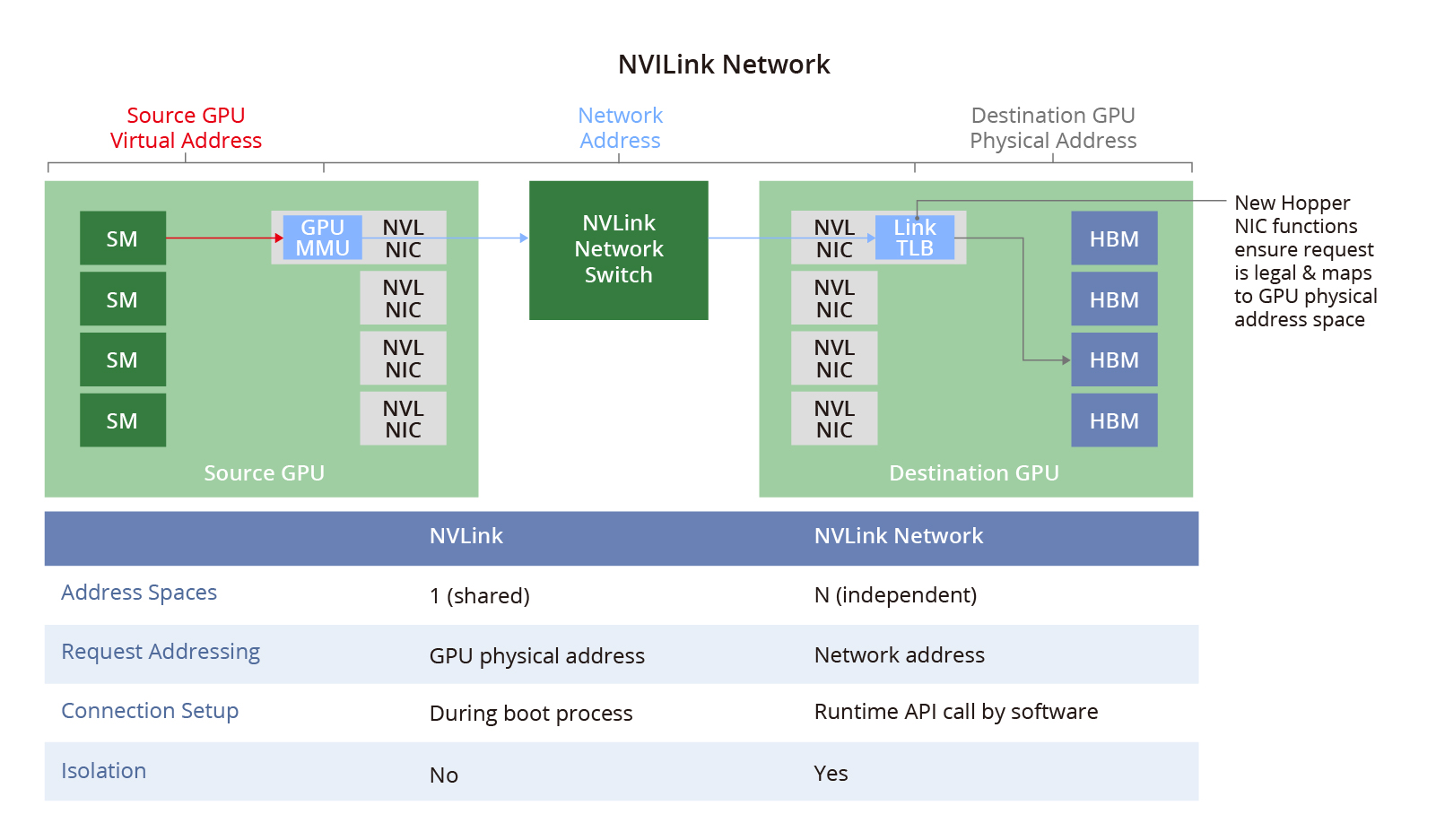

NVLink网络

NVSwitch物理交换机将多个NVLink GPU服务器连接成一个大型Fabric网络,即NVLink网络,解决了GPU之间的高速通信带宽和效率问题。每个服务器都有独立的地址空间,为NVLink网络中的GPU提供数据传输、隔离和安全保护。当系统启动时,NVLink网络通过软件API自动建立连接,并可以在运行过程中更改地址。

NVLink网络

NVSwitch物理交换机将多个NVLink GPU服务器连接成一个大型Fabric网络,即NVLink网络,解决了GPU之间的高速通信带宽和效率问题。每个服务器都有独立的地址空间,为NVLink网络中的GPU提供数据传输、隔离和安全保护。当系统启动时,NVLink网络通过软件API自动建立连接,并可以在运行过程中更改地址。

该图比较了NVLink网络与传统以太网网络,演示了如何创建独立于IP以太网并专用于GPU服务的NVLink网络。

该图比较了NVLink网络与传统以太网网络,演示了如何创建独立于IP以太网并专用于GPU服务的NVLink网络。

| 概念 | 传统实例 | NVLink网络 |

| 物理层 | 400G电/光介质 | 定制固件 OSFP |

| 数据链路层 | 以太网 | NVLink定制芯片上的硬件和固件 |

| 网络层 | IP | 新NVLink网络寻址和管理协议 |

| 传输层 | TCP | NVLink定制芯片上的硬件和固件 |

| 会话层 | Socket | SHARP组 CUDA导出数据结构的网络地址 |

| 应用层 | HTTP/FTP | 计算框架或用户应用程序 |

| 网卡 | PCIe网卡 (网卡或芯片) | 嵌入在GPU和NVSwitch中的函数 |

| RDMA卸载 | 网卡卸载引擎 | GPU内部复制引擎 |

结论

NVIDIA NVLink作为一项开创性的技术,彻底改变了高性能计算领域。它能够增强GPU之间的通信,提高性能,并实现无缝的并行处理,成为众多高性能计算应用中不可或缺的组成部分。随着先进计算领域的不断发展,NVLink的重要性和影响力将不断扩大,推动技术创新。汇鑫科服隶属于北京通忆汇鑫科技有限公司, 成立于2007年,是一家互联网+、物联网、人工智能、大数据技术应用公司,专注于楼宇提供智能化产品与服务。致力服务写字楼内发展中的中小企业 ,2009年首创楼宇通信BOO模式,以驻地网运营模式为楼宇提供配套运营服务;汇鑫科服始终以客户管理效率为导向,一站式 ICT服务平台,提升写字楼办公场景的办公效率和体验;

结论

NVIDIA NVLink作为一项开创性的技术,彻底改变了高性能计算领域。它能够增强GPU之间的通信,提高性能,并实现无缝的并行处理,成为众多高性能计算应用中不可或缺的组成部分。随着先进计算领域的不断发展,NVLink的重要性和影响力将不断扩大,推动技术创新。汇鑫科服隶属于北京通忆汇鑫科技有限公司, 成立于2007年,是一家互联网+、物联网、人工智能、大数据技术应用公司,专注于楼宇提供智能化产品与服务。致力服务写字楼内发展中的中小企业 ,2009年首创楼宇通信BOO模式,以驻地网运营模式为楼宇提供配套运营服务;汇鑫科服始终以客户管理效率为导向,一站式 ICT服务平台,提升写字楼办公场景的办公效率和体验;