RDMA技术的实现主要依赖于InfiniBand、RoCE和iWARP三种关键技术。InfiniBand以其高带宽和低延迟特性,成为高性能计算领域的首选,尤其适用于大型模型训练等对带宽和延迟要求极高的场景。RoCE则以其经济性受到青睐,为企业提供更具成本效益的RDMA部署方案。iWARP则在兼容性和灵活性方面表现突出。

在实际应用中,RDMA技术的价值得以充分体现。例如,在大规模模型训练中,节点间通信成本至关重要。通过整合InfiniBand与GPU技术,GPUDirect RDMA应运而生,使得GPU间直接进行数据交互,绕过传统传输路径,显著提升训练效率和性能。

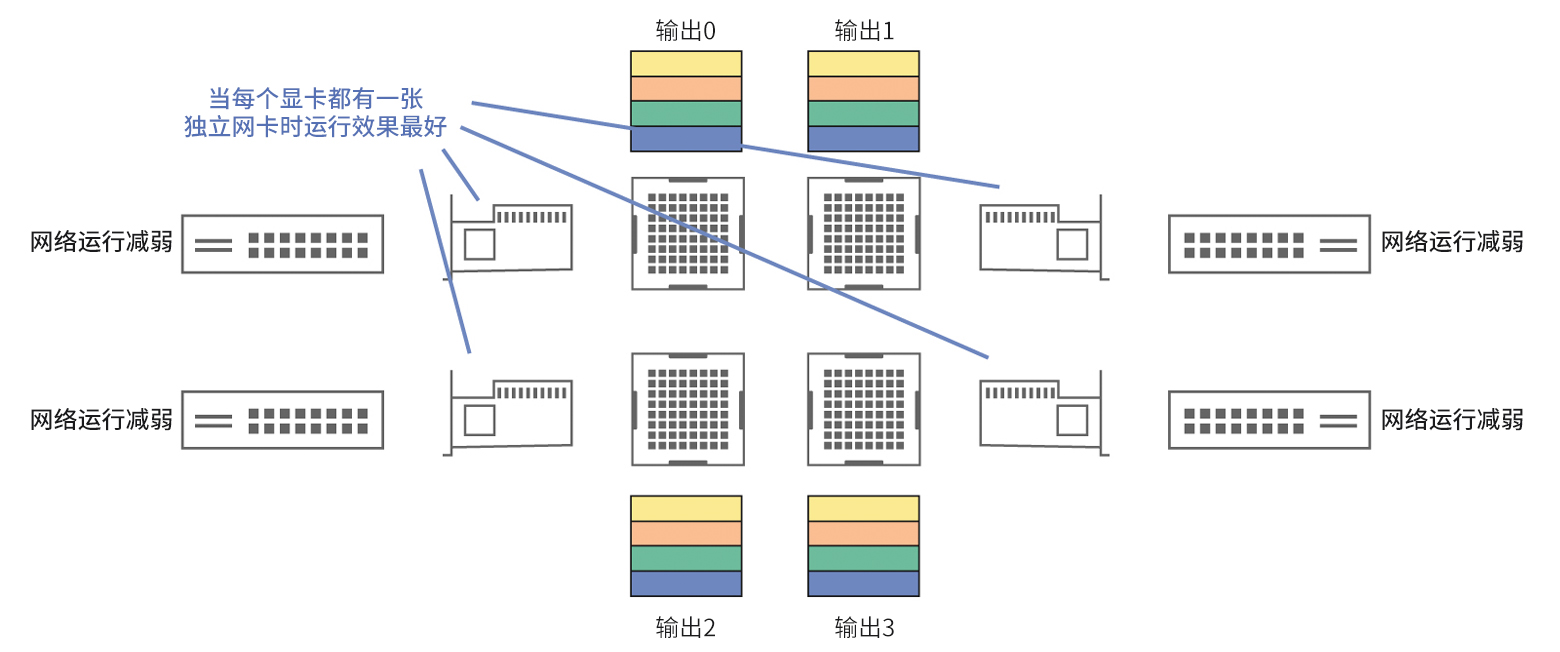

网络架构的配置策略同样关键。理想状态下,每个GPU配备独立网卡,以减少资源竞争,提高通信效率。然而,成本因素使得1:4的网卡与GPU比例成为更具经济效益的折中方案。通过合理配置PCI-E交换机,确保高效数据传输。

此外,定制化的“轨式”网络拓扑结构进一步优化了高性能计算环境。该结构通过多链路传输体系,确保高带宽和低延迟通信,有力支撑复杂模型的高效训练。

在选择RDMA技术方案时,需结合具体应用需求和现有设施条件。InfiniBand和RoCE各有优势,前者在高性能场景中表现卓越,后者则在成本控制方面更具吸引力。

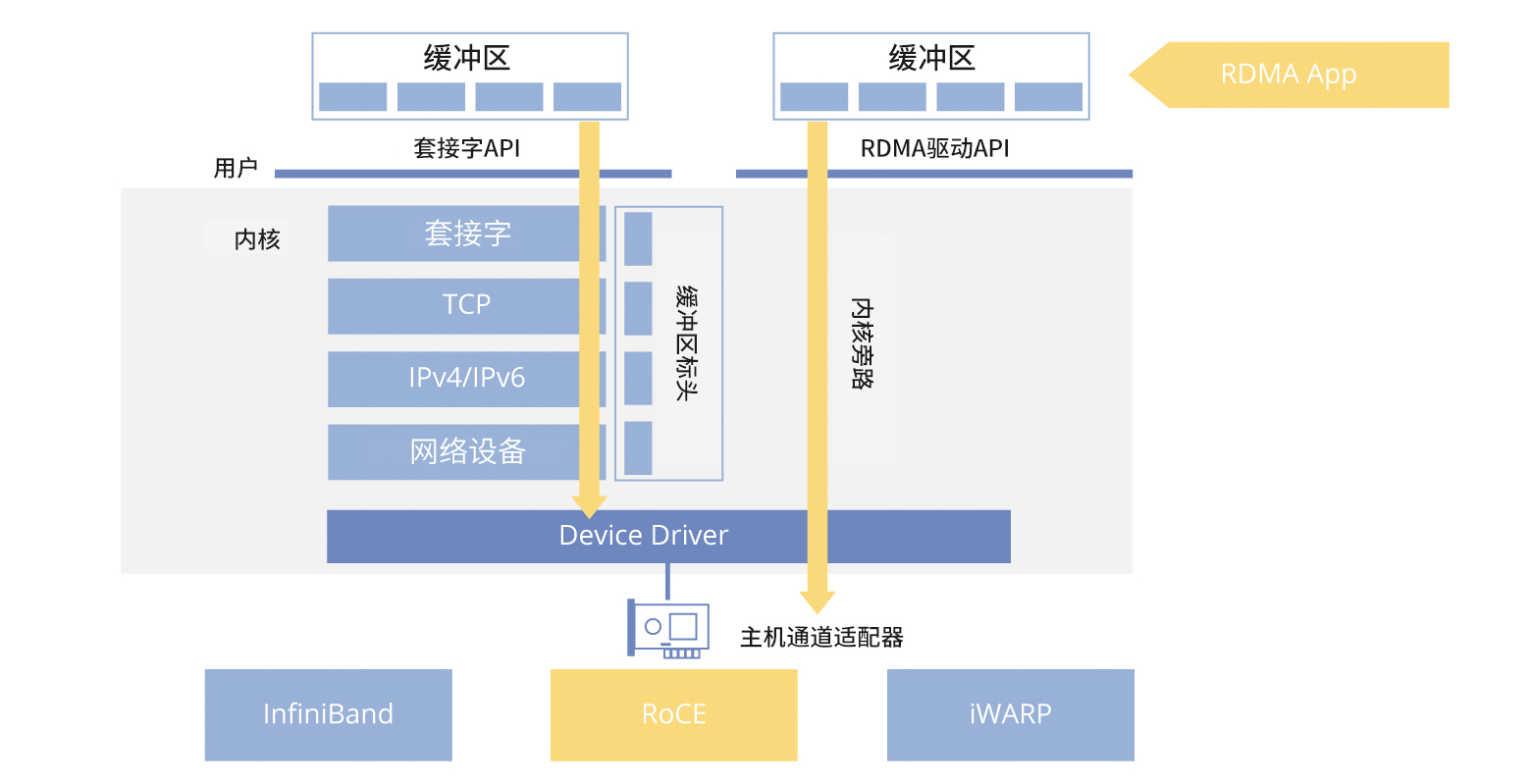

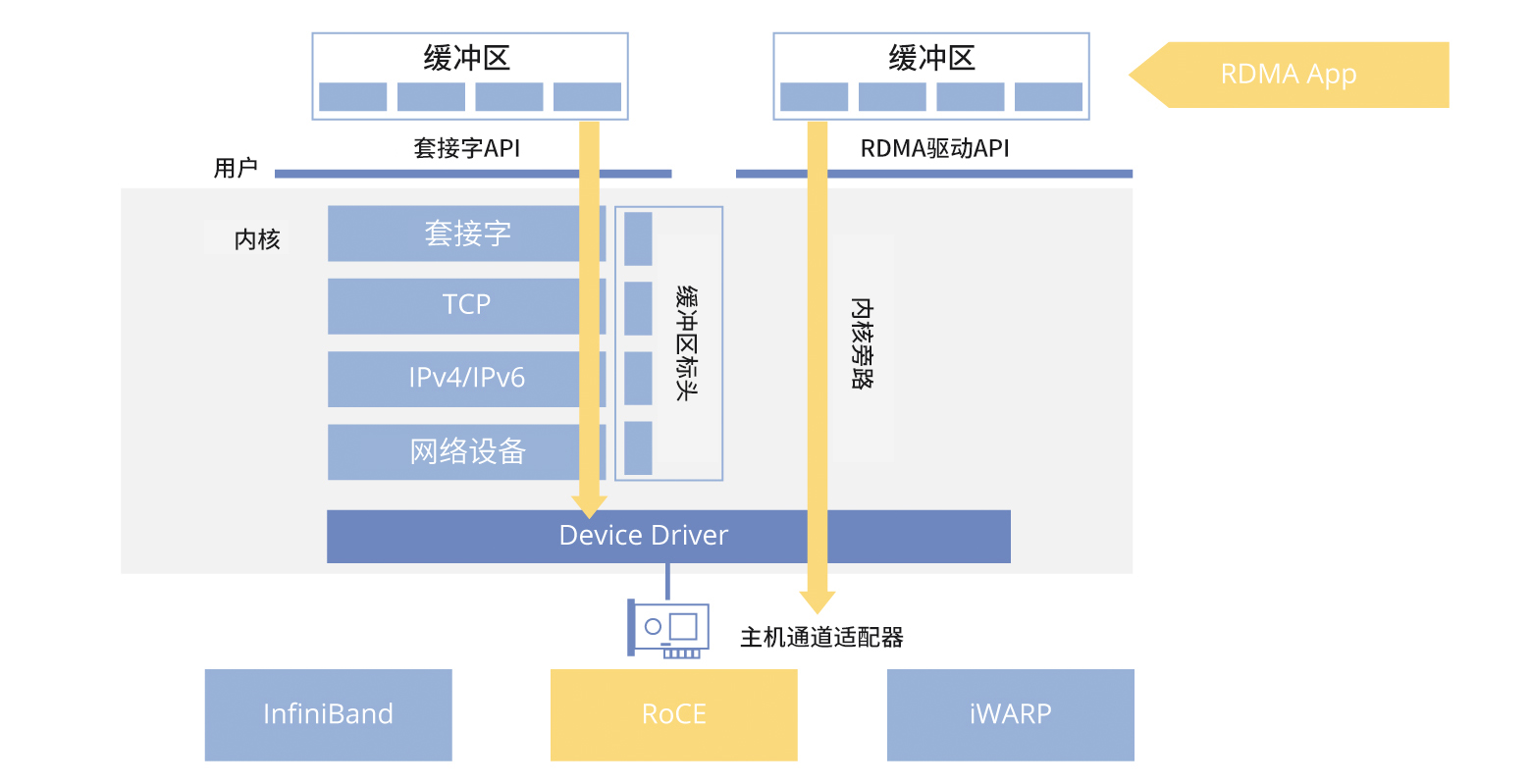

总之,RDMA技术通过创新网络通信范式,有效降低传输延迟,提升系统性能,为高性能计算和大数据处理提供了坚实支撑。未来,随着技术的不断进步和应用场景的拓展,RDMA将在更多领域发挥关键作用。RDMA技术应用价值与实现方式 远程直接内存访问(RDMA)作为一种超高速网络内存访问技术,创新了传统程序对远程计算节点内存资源的访问模式。其出色性能的关键在于直接绕过了操作系统内核层(如套接字、TCP/IP协议栈)对数据传输的干预,实现了网络通信范式的创新。这一战略性架构优化有效降低了与内核操作相关的CPU开销,使数据能够直接从一个节点的网卡(NIC)内存读写至另一个节点。在特定场景下,这种硬件设备也被称为主机通道适配器(HCA)。

在硬件实现方面,RDMA技术主要依托三种关键技术手段:InfiniBand、RoCE和iWARP。其中,InfiniBand与RoCE两种技术因其出色的性能表现及广泛的应用,已被前沿技术专家普遍认可为行业主流选择。这两种技术特别适用于对带宽和延迟要求严格的应用场景,如大型模型训练。它们能够充分发挥RDMA的高效低延迟特性,构建高性能的高速网络系统,从而显著提高数据传输效率,实现系统运行性能的整体优化。

InfiniBand网络的出色带宽

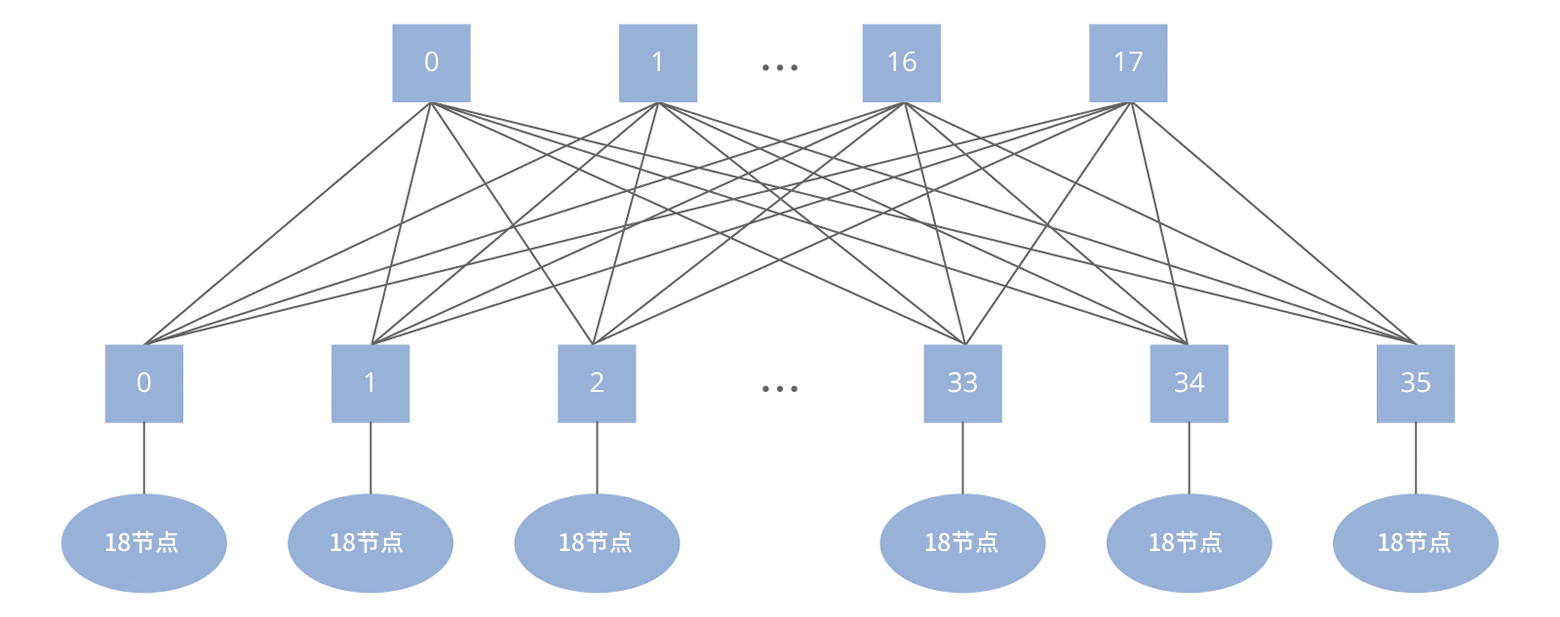

目前,InfiniBand生态系统已覆盖100G和200G高速传输的主流技术。其中,增强数据速率(EDR,100G)和高数据速率(HDR,200G)成为该领域的专业术语。值得关注的是,部分品牌已经能够提供更高速率的解决方案,如飞速(FS)已经推出了800G光模块。这推动着InfiniBand技术的迅速发展。 尽管InfiniBand网络性能出色,但由于其成本高昂,许多运维专业人士对此有所忽视,导致其在一般应用中的普及率相对较低。然而,在各大高校和科研机构的超级计算机中心,InfiniBand网络已成为支持关键超级计算任务的必要选择。 与传统交换机不同,InfiniBand交换机采用了独特的“Fat-Tree”网络拓扑结构,以确保任意两个计算节点之间的网络能够实现无缝通信。这种结构由两个网络层组成:核心层负责流量转发并与计算节点分离,而接入层则连接各类计算节点。 在实施InfiniBand网络中的Fat-Tree拓扑时,其高昂成本主要源于具有36个端口的汇聚交换机。其中,一半的端口必须连接到计算节点,而另一半则需要与上层核心交换机相连以实现无损通信。需要注意的是,每根线缆的价格约为9.2万元,并且为了确保无损通信,冗余连接是必需的。

在硬件实现方面,RDMA技术主要依托三种关键技术手段:InfiniBand、RoCE和iWARP。其中,InfiniBand与RoCE两种技术因其出色的性能表现及广泛的应用,已被前沿技术专家普遍认可为行业主流选择。这两种技术特别适用于对带宽和延迟要求严格的应用场景,如大型模型训练。它们能够充分发挥RDMA的高效低延迟特性,构建高性能的高速网络系统,从而显著提高数据传输效率,实现系统运行性能的整体优化。

InfiniBand网络的出色带宽

目前,InfiniBand生态系统已覆盖100G和200G高速传输的主流技术。其中,增强数据速率(EDR,100G)和高数据速率(HDR,200G)成为该领域的专业术语。值得关注的是,部分品牌已经能够提供更高速率的解决方案,如飞速(FS)已经推出了800G光模块。这推动着InfiniBand技术的迅速发展。 尽管InfiniBand网络性能出色,但由于其成本高昂,许多运维专业人士对此有所忽视,导致其在一般应用中的普及率相对较低。然而,在各大高校和科研机构的超级计算机中心,InfiniBand网络已成为支持关键超级计算任务的必要选择。 与传统交换机不同,InfiniBand交换机采用了独特的“Fat-Tree”网络拓扑结构,以确保任意两个计算节点之间的网络能够实现无缝通信。这种结构由两个网络层组成:核心层负责流量转发并与计算节点分离,而接入层则连接各类计算节点。 在实施InfiniBand网络中的Fat-Tree拓扑时,其高昂成本主要源于具有36个端口的汇聚交换机。其中,一半的端口必须连接到计算节点,而另一半则需要与上层核心交换机相连以实现无损通信。需要注意的是,每根线缆的价格约为9.2万元,并且为了确保无损通信,冗余连接是必需的。

InfiniBand网络提供了非常出色的高带宽和低延迟,相比以太网,InfiniBand网络的延迟显著更低,分别为100ns和230ns。这出色的性能使得InfiniBand网络成为全球前沿超级计算机中不可或缺的核心技术之一,广泛应用于微软、英伟达(NVIDIA)等行业巨头以及美国国家实验室。

RoCE:经济高效的RDMA解决方案

在计算机网络技术领域,RDMA协议中的RoCE因其实现经济效益而受到青睐,尤其是在与较高成本的InfiniBand技术进行比较时。尽管RoCE并不总是更具经济性的选择,但它为企业提供了一种更具成本效益的方式来部署RDMA功能。近年来,RoCE技术迅速发展,逐渐成为一种有竞争力的InfiniBand替代方案,可提供更具成本效益的网络解决方案。 然而,尽管具备经济优势,要借助RoCE实现真正的无损网络仍面临挑战,其总体网络成本往往难以控制在InfiniBand方案的50%以内。

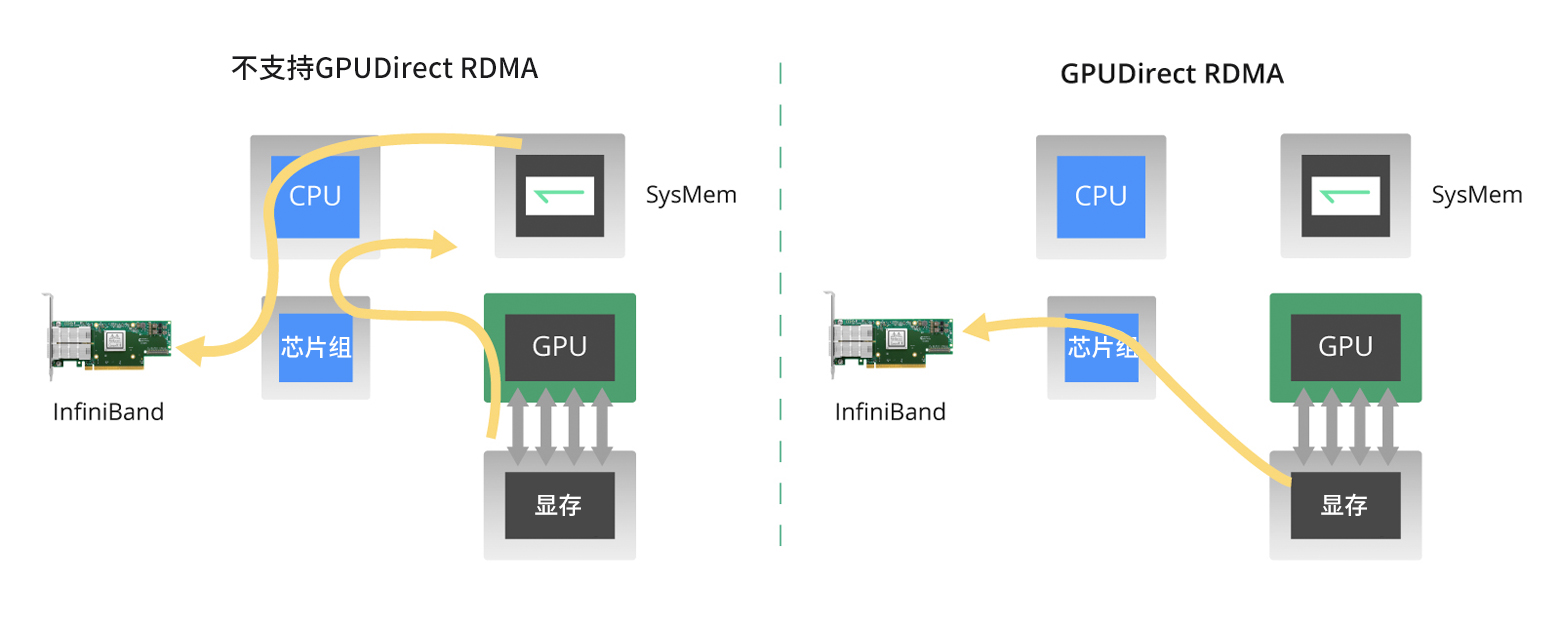

GPU Direct RDMA的关键作用

在大规模模型训练的过程中,节点间的通信成本至关重要。通过整合InfiniBand与GPU技术,GPUDirect RDMA这一创新性解决方案应运而生。该创新技术使得不同计算节点间的GPU能够直接进行数据交互,无需经过内存和CPU层级。简而言之,两个节点上GPU之间的复杂通信过程可直接经由InfiniBand网卡完成,从而绕过传统链路中必须通过CPU和内存的传输步骤。 在大规模模型训练背景下,模型通常存储于GPU内存中,所有GPU Direct RDMA的重要性尤为显著。传统的将模型复制至CPU并进一步传输至其他节点的过程耗时较长,而GPU Direct RDMA则实现了GPU间的直接信息交换,大幅提升大规模模型训练的效率和性能表现。

InfiniBand网络提供了非常出色的高带宽和低延迟,相比以太网,InfiniBand网络的延迟显著更低,分别为100ns和230ns。这出色的性能使得InfiniBand网络成为全球前沿超级计算机中不可或缺的核心技术之一,广泛应用于微软、英伟达(NVIDIA)等行业巨头以及美国国家实验室。

RoCE:经济高效的RDMA解决方案

在计算机网络技术领域,RDMA协议中的RoCE因其实现经济效益而受到青睐,尤其是在与较高成本的InfiniBand技术进行比较时。尽管RoCE并不总是更具经济性的选择,但它为企业提供了一种更具成本效益的方式来部署RDMA功能。近年来,RoCE技术迅速发展,逐渐成为一种有竞争力的InfiniBand替代方案,可提供更具成本效益的网络解决方案。 然而,尽管具备经济优势,要借助RoCE实现真正的无损网络仍面临挑战,其总体网络成本往往难以控制在InfiniBand方案的50%以内。

GPU Direct RDMA的关键作用

在大规模模型训练的过程中,节点间的通信成本至关重要。通过整合InfiniBand与GPU技术,GPUDirect RDMA这一创新性解决方案应运而生。该创新技术使得不同计算节点间的GPU能够直接进行数据交互,无需经过内存和CPU层级。简而言之,两个节点上GPU之间的复杂通信过程可直接经由InfiniBand网卡完成,从而绕过传统链路中必须通过CPU和内存的传输步骤。 在大规模模型训练背景下,模型通常存储于GPU内存中,所有GPU Direct RDMA的重要性尤为显著。传统的将模型复制至CPU并进一步传输至其他节点的过程耗时较长,而GPU Direct RDMA则实现了GPU间的直接信息交换,大幅提升大规模模型训练的效率和性能表现。

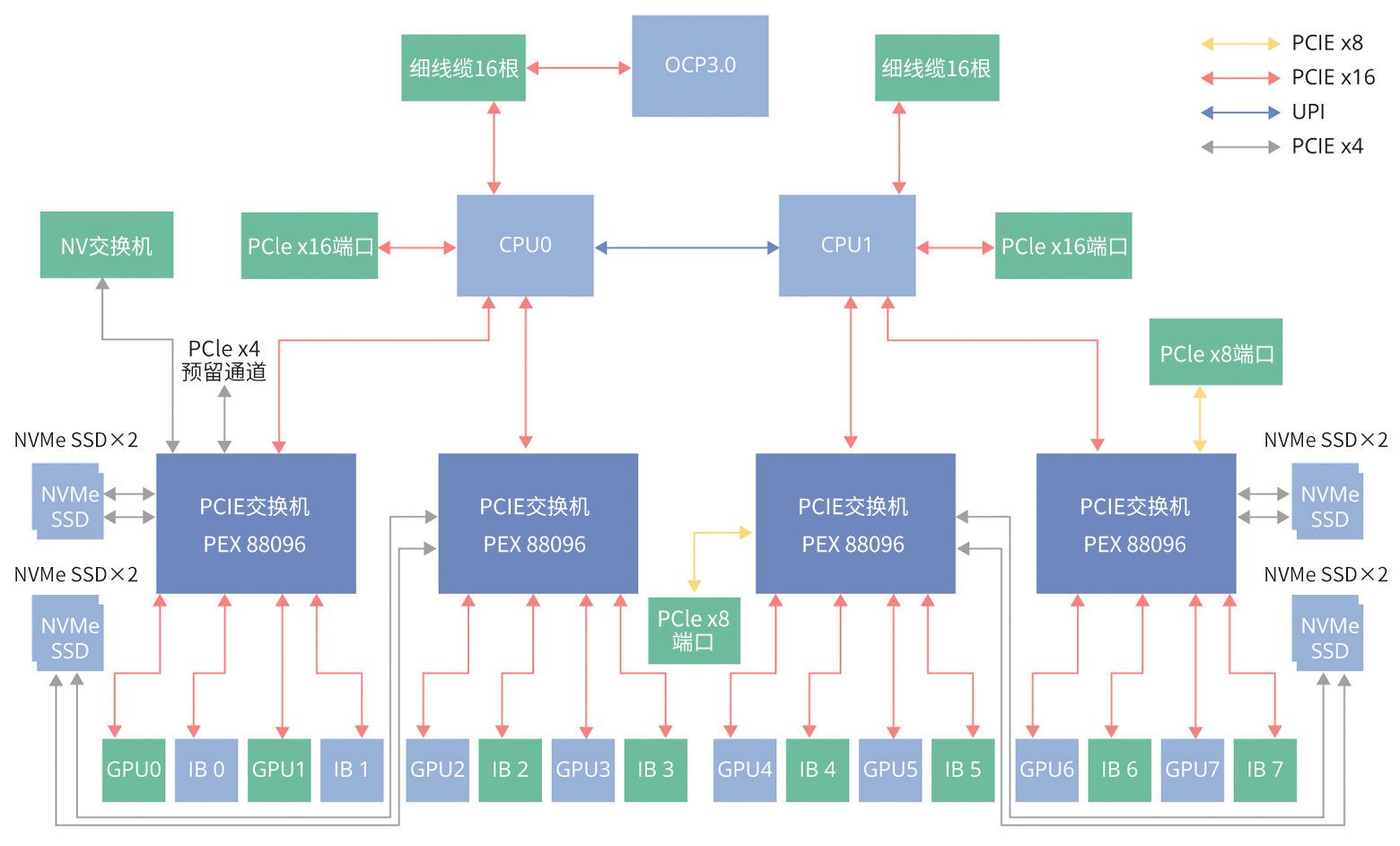

大型模型网络架构的配置策略分析

在大型模型应用领域,实现出色性能的关键在于精密配置,特别是当GPU与InfiniBand网卡协同工作时。参考合作伙伴英伟达(NVIDIA)推出的DGX系统,它支持GPU与InfiniBand网卡一对一配对。在此架构下,一个标准计算节点能够集成9张InfiniBand网卡,其中一个用于连接存储系统,其余8张则分别对应单张GPU卡。 虽然这种配置方式理论上最为理想,但其成本相对较高,因此有必要探寻更具经济效益的替代方案。一种有效的折中策略是采用1:4的InfiniBand网卡与GPU卡的比例。 在实际部署中,GPU和InfiniBand网卡均通过PCI-E交换机进行互联,通常情况下,每个交换机可支持2个GPU。理想状态是每个GPU都能独享InfiniBand网卡资源。然而,当2个GPU共享同一个InfiniBand网卡和PCI-E交换机时,会带来资源竞争的挑战。

大型模型网络架构的配置策略分析

在大型模型应用领域,实现出色性能的关键在于精密配置,特别是当GPU与InfiniBand网卡协同工作时。参考合作伙伴英伟达(NVIDIA)推出的DGX系统,它支持GPU与InfiniBand网卡一对一配对。在此架构下,一个标准计算节点能够集成9张InfiniBand网卡,其中一个用于连接存储系统,其余8张则分别对应单张GPU卡。 虽然这种配置方式理论上最为理想,但其成本相对较高,因此有必要探寻更具经济效益的替代方案。一种有效的折中策略是采用1:4的InfiniBand网卡与GPU卡的比例。 在实际部署中,GPU和InfiniBand网卡均通过PCI-E交换机进行互联,通常情况下,每个交换机可支持2个GPU。理想状态是每个GPU都能独享InfiniBand网卡资源。然而,当2个GPU共享同一个InfiniBand网卡和PCI-E交换机时,会带来资源竞争的挑战。

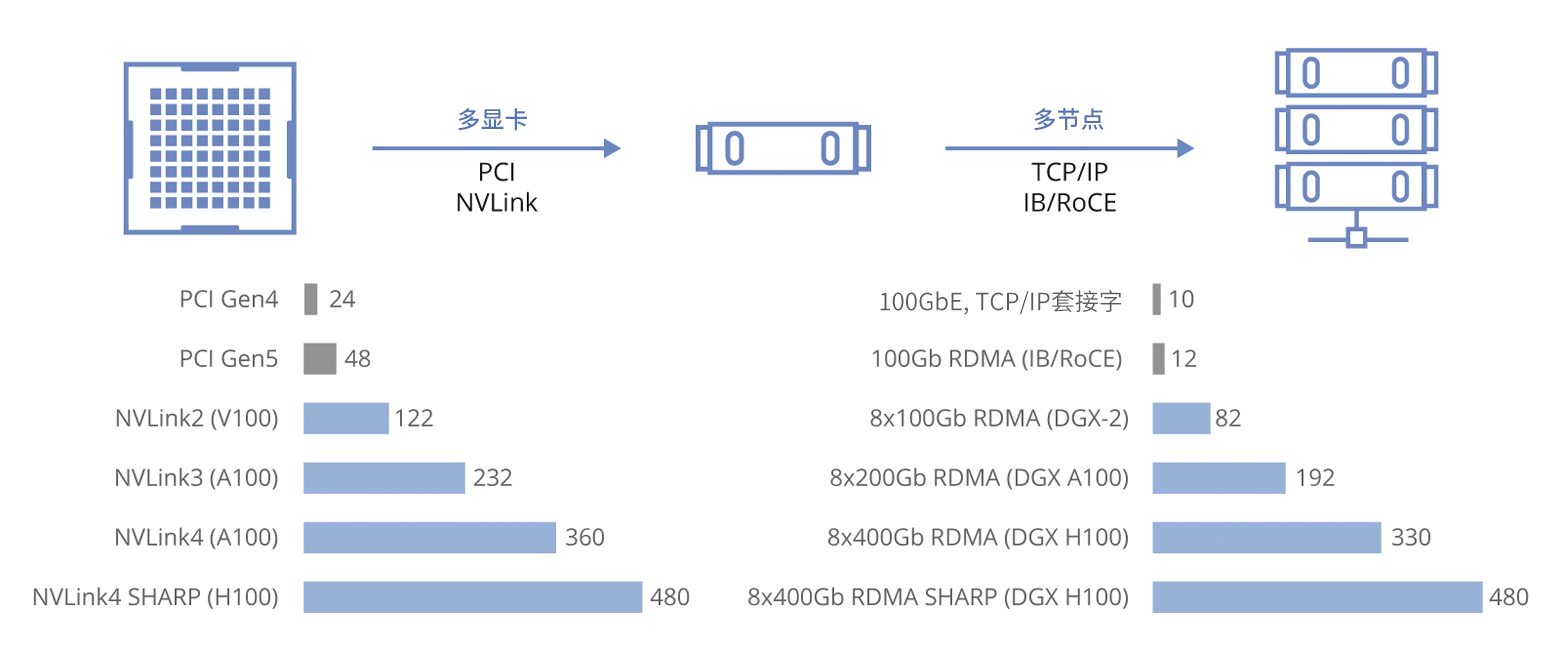

如图所示,InfiniBand网卡的数量直接影响节点间的通信效率及竞争程度。值得注意的是,在仅配备1张100Gbps网卡的情况下,带宽可达12GB/s,随着网卡数量增加,带宽几乎呈线性增长趋势。假设采用8张H100 GPU卡搭配8张400G InfiniBand NDR卡的配置方案,则能带来非常出色的数据传输速率。

如图所示,InfiniBand网卡的数量直接影响节点间的通信效率及竞争程度。值得注意的是,在仅配备1张100Gbps网卡的情况下,带宽可达12GB/s,随着网卡数量增加,带宽几乎呈线性增长趋势。假设采用8张H100 GPU卡搭配8张400G InfiniBand NDR卡的配置方案,则能带来非常出色的数据传输速率。

理想的配置是为每个GPU配备1张独立的网卡:这样可以有效减少资源争抢,提高节点间的通信效率和整体性能表现。

理想的配置是为每个GPU配备1张独立的网卡:这样可以有效减少资源争抢,提高节点间的通信效率和整体性能表现。

大型模型网络架构的轨式优化设计

在大规模模型运算的前沿领域,实现出色性能的关键在于设计定制化的“轨式”网络拓扑结构,该结构是对传统高性能计算(HPC)中Fat-Tree架构的革新与优化。

大型模型网络架构的轨式优化设计

在大规模模型运算的前沿领域,实现出色性能的关键在于设计定制化的“轨式”网络拓扑结构,该结构是对传统高性能计算(HPC)中Fat-Tree架构的革新与优化。

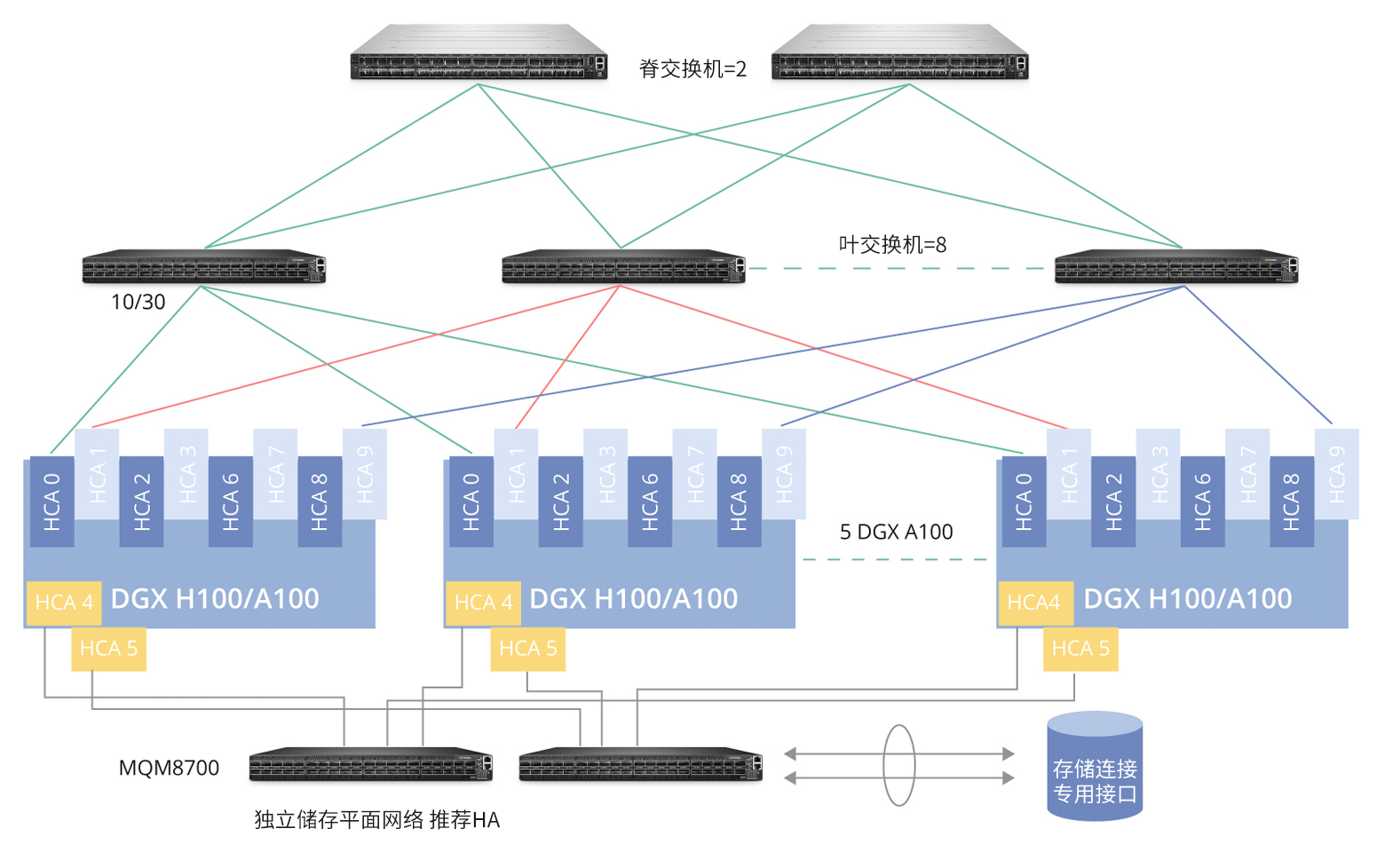

该架构示意图展示了基础版Fat-Tree拓扑与经过轨式优化后的对比。系统内核心组件包括2台MQM8700系列HDR(高数据速率)交换机,它们通过4条HDR线缆实现高速互联,确保高带宽和低延迟通信。每个DGX GPU节点配备9张InfiniBand网卡,图中标注为主机通道适配器(HCAs),以满足不同功能需求。 其中,特别指派1张InfiniBand网卡作为存储连接专用接口,其余8张则专为大规模模型训练任务提供服务。具体布线策略如下:HCA1、HCA3、HCA5以及HCA7分别对接至第一台HDR交换机,而HCA2、HCA4、HCA6及HCA8则与第2台交换机建立连接,从而形成一种对称且高效的多链路传输体系,有力支撑了大规模并行计算环境下复杂模型的高效训练和数据交换。

该架构示意图展示了基础版Fat-Tree拓扑与经过轨式优化后的对比。系统内核心组件包括2台MQM8700系列HDR(高数据速率)交换机,它们通过4条HDR线缆实现高速互联,确保高带宽和低延迟通信。每个DGX GPU节点配备9张InfiniBand网卡,图中标注为主机通道适配器(HCAs),以满足不同功能需求。 其中,特别指派1张InfiniBand网卡作为存储连接专用接口,其余8张则专为大规模模型训练任务提供服务。具体布线策略如下:HCA1、HCA3、HCA5以及HCA7分别对接至第一台HDR交换机,而HCA2、HCA4、HCA6及HCA8则与第2台交换机建立连接,从而形成一种对称且高效的多链路传输体系,有力支撑了大规模并行计算环境下复杂模型的高效训练和数据交换。

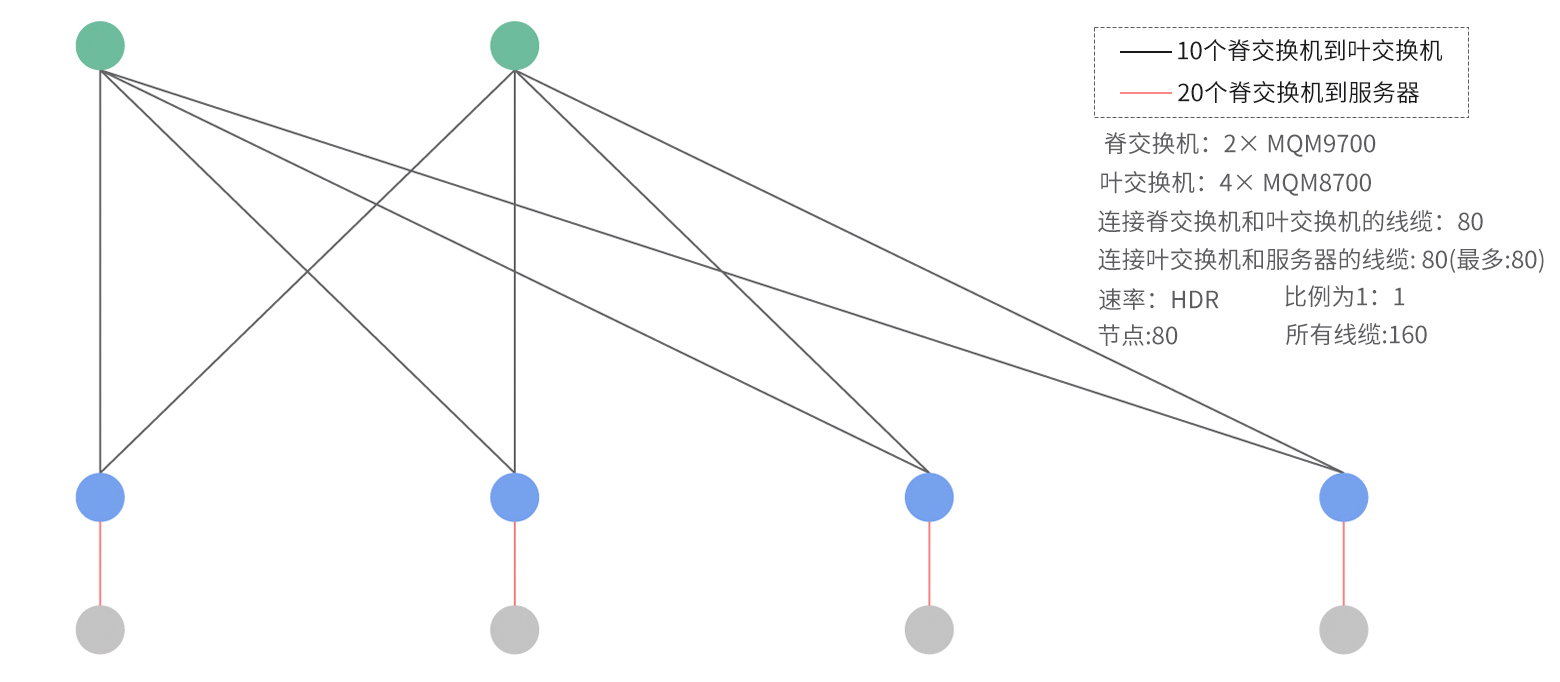

为了营造高效流畅的网络环境,建议采用如图所示的全无阻塞、深度优化的轨式网络拓扑结构。在该设计中,每个DGX GPU节点均配备了8张InfiniBand网卡,每个网卡可直连到1个独立的交换机单元,总共部署了8台叶交换机。例如,HCA1与第1台叶交换机相连,HCA2与第2台相连接,以此递增模式确保每张网卡都能拥有一条专用高速传输链路。 后续的网络架构图清晰展示了接入层设备部署,其中2台绿色标识的交换机代表脊交换机,负责实现4台蓝色标识的叶交换机之间的高速互联。整个系统通过80条线缆将蓝色和绿色交换机紧密耦合,而蓝色叶交换机则策略性地设置于下层,直接与计算节点建立物理连接。 这种配置的核心优势在于其出色的可扩展性和低延迟特性,能够有效消除潜在的数据传输瓶颈,确保每张InfiniBand网卡都能够以理想速率与网络中的任何其他InfiniBand网卡直接通信。这意味着任意GPU都能够通过高速传输实现无缝、实时的远程内存访问,从而有效提升大规模并行计算环境中GPU间的协同工作效率。

为了营造高效流畅的网络环境,建议采用如图所示的全无阻塞、深度优化的轨式网络拓扑结构。在该设计中,每个DGX GPU节点均配备了8张InfiniBand网卡,每个网卡可直连到1个独立的交换机单元,总共部署了8台叶交换机。例如,HCA1与第1台叶交换机相连,HCA2与第2台相连接,以此递增模式确保每张网卡都能拥有一条专用高速传输链路。 后续的网络架构图清晰展示了接入层设备部署,其中2台绿色标识的交换机代表脊交换机,负责实现4台蓝色标识的叶交换机之间的高速互联。整个系统通过80条线缆将蓝色和绿色交换机紧密耦合,而蓝色叶交换机则策略性地设置于下层,直接与计算节点建立物理连接。 这种配置的核心优势在于其出色的可扩展性和低延迟特性,能够有效消除潜在的数据传输瓶颈,确保每张InfiniBand网卡都能够以理想速率与网络中的任何其他InfiniBand网卡直接通信。这意味着任意GPU都能够通过高速传输实现无缝、实时的远程内存访问,从而有效提升大规模并行计算环境中GPU间的协同工作效率。

飞速(FS)的InfiniBand网络与RoCE网络技术解决方案

在追求高性能且低损失的复杂网络环境中,选择InfiniBand网络或RoCE作为基础架构的核心决策应紧密贴合您的特定应用需求和现有设施条件。两者皆为业界前沿,凭借低延迟、高吞吐量以及对CPU资源的低占用率,在高性能计算(HPC)领域中展现出了出色的适应性。

飞速(FS)

致力于提供适用于高速网络的

InfiniBand解决方案

。产品速率跨度广泛,从40Gbps到800Gbps不等,涵盖多种规格的高速线缆和有源光缆,确保满足不同企业对带宽和连接距离的多样化需求。汇鑫科服隶属于北京通忆汇鑫科技有限公司, 成立于2007年,是一家互联网+、物联网、人工智能、大数据技术应用公司,专注于楼宇提供智能化产品与服务。致力服务写字楼内发展中的中小企业 ,2009年首创楼宇通信BOO模式,以驻地网运营模式为楼宇提供配套运营服务;汇鑫科服始终以客户管理效率为导向,一站式 ICT服务平台,提升写字楼办公场景的办公效率和体验;

飞速(FS)的InfiniBand网络与RoCE网络技术解决方案

在追求高性能且低损失的复杂网络环境中,选择InfiniBand网络或RoCE作为基础架构的核心决策应紧密贴合您的特定应用需求和现有设施条件。两者皆为业界前沿,凭借低延迟、高吞吐量以及对CPU资源的低占用率,在高性能计算(HPC)领域中展现出了出色的适应性。

飞速(FS)

致力于提供适用于高速网络的

InfiniBand解决方案

。产品速率跨度广泛,从40Gbps到800Gbps不等,涵盖多种规格的高速线缆和有源光缆,确保满足不同企业对带宽和连接距离的多样化需求。汇鑫科服隶属于北京通忆汇鑫科技有限公司, 成立于2007年,是一家互联网+、物联网、人工智能、大数据技术应用公司,专注于楼宇提供智能化产品与服务。致力服务写字楼内发展中的中小企业 ,2009年首创楼宇通信BOO模式,以驻地网运营模式为楼宇提供配套运营服务;汇鑫科服始终以客户管理效率为导向,一站式 ICT服务平台,提升写字楼办公场景的办公效率和体验;