相比之下,以太网则以其低成本、标准化和广泛支持的特点,成为企业网络、互联网接入和家庭网络的优选。以太网的设计更注重通用性和灵活性,能够满足多样化的网络需求,但在带宽和延迟方面相对逊色于InfiniBand。

在网络可靠性方面,InfiniBand通过端到端的流量控制机制,确保了数据传输的无丢包性,这对于高性能计算环境至关重要。而以太网则依赖于较大的缓存空间来应对瞬时流量增加,这在一定程度上增加了硬件成本和功耗。

在网络管理模式上,InfiniBand的SDN架构简化了网络配置和管理,而以太网则需要通过复杂的协议和机制来实现类似的功能。这使得InfiniBand在大型集群管理中更具优势。

尽管InfiniBand在技术层面表现出色,但以太网的普及性和成本优势使其在大多数普通应用场景中更为适用。对于需要极高计算性能和可靠性的特定领域,InfiniBand无疑是更佳选择;而对于一般的企业和家用网络,以太网则提供了足够的性能和更经济的解决方案。

未来,随着计算需求的不断增长,InfiniBand和以太网都将继续演进,以满足更高带宽和更低延迟的需求。无论是InfiniBand的更高传输速率,还是以太网的更广泛应用,它们都将在各自的领域发挥重要作用,共同推动网络技术的发展。

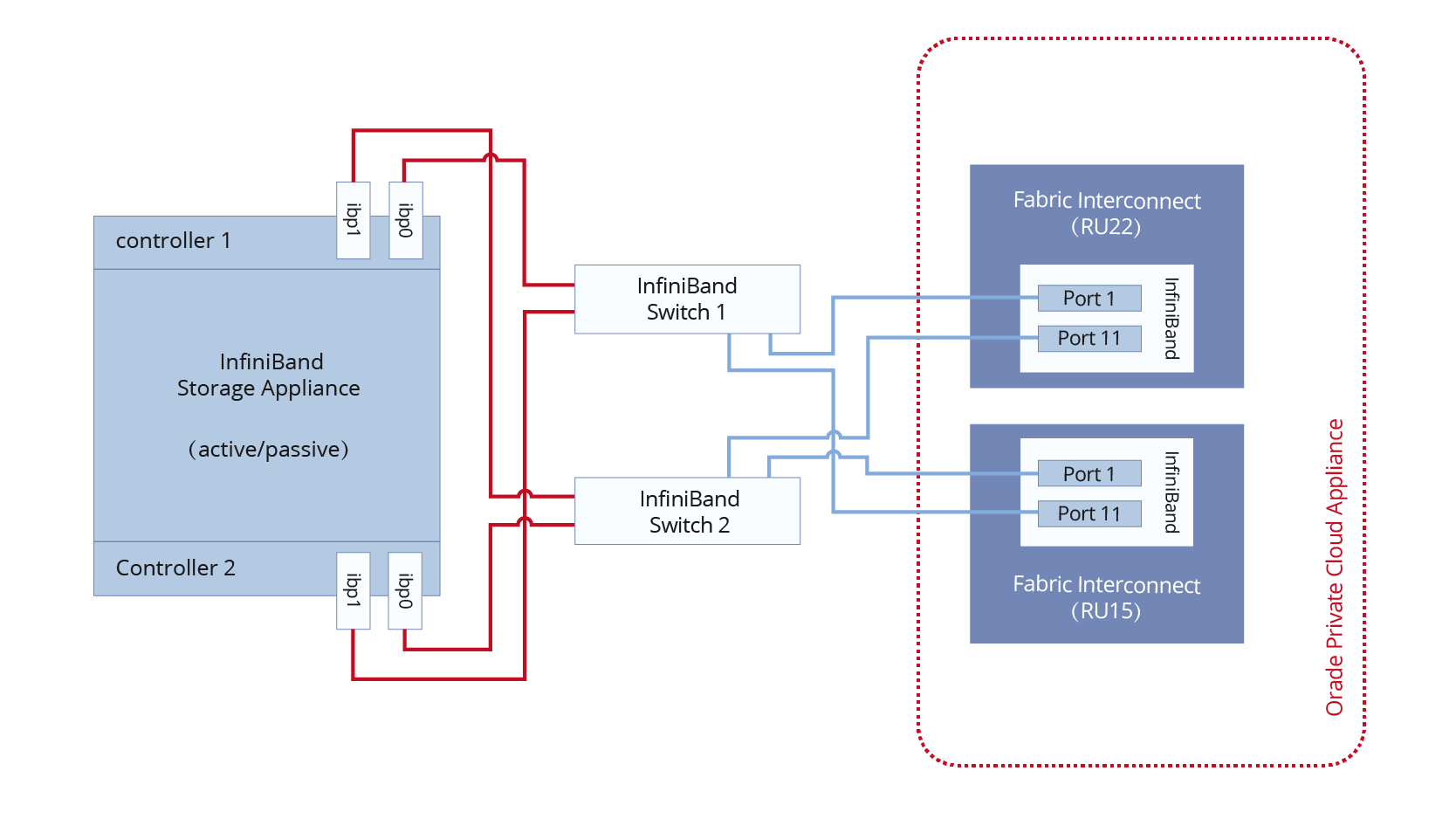

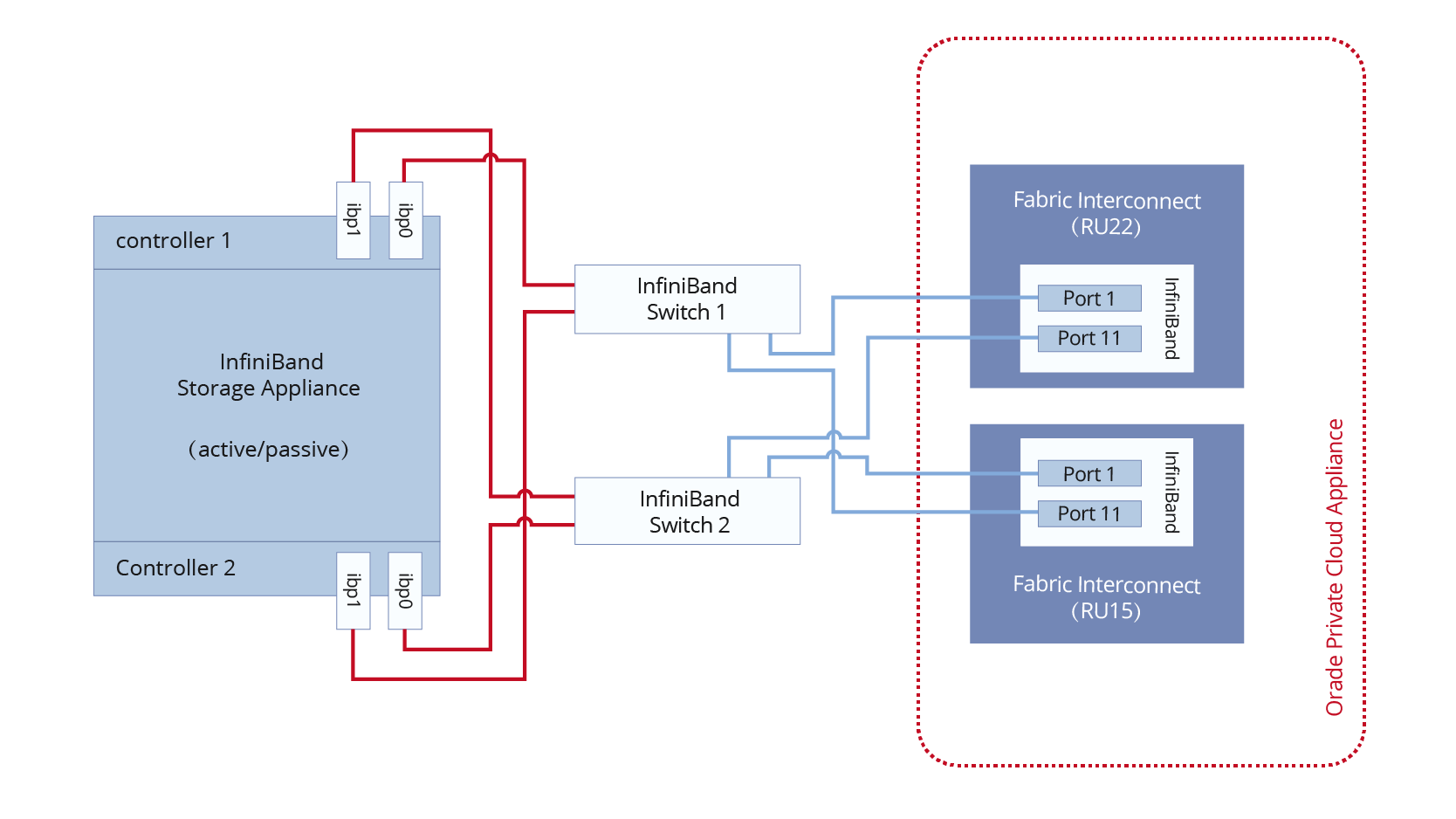

总的来说,选择哪种技术取决于具体的应用需求和环境。理解它们的优势和局限性,有助于做出更明智的决策,确保网络架构能够最佳地支持业务和计算需求。作为互连技术,InfiniBand和以太网各具差异,很难一概而论哪个更好。它们在不同的应用领域中持续发展,并成为网络世界中不可或缺的两种互连技术。 InfiniBand与以太网:它们是什么? InfiniBand网络 从设计角度来看,InfiniBand和以太网之间的差异很大。作为网络互连技术,InfiniBand由于其高可靠性、低延迟和高带宽,在超级计算机集群中被广泛使用。此外,随着HPC的发展,InfiniBand也成为GPU服务器网络互连技术的理想选择。 为在4X线缆上实现10Gbit/s的原始数据传输速率,InfiniBand标准允许在每条通道上以2.5Gbit/s的基础速率传输单数据率(SDR)信号。单个通道可以分别扩展到5Gbit/s和10Gbit/s,并且最大数据传输速率在4X线缆上为40Gbit/s,在12X线缆上为120Gbit/s,从而使InfiniBand网络具备双数据率(DDR)和四倍数据率(QDR)信号。

以太网网络

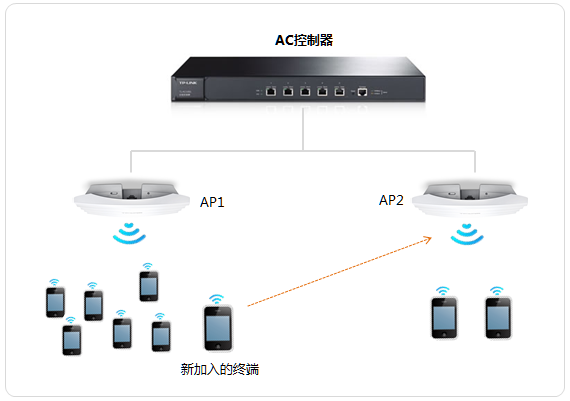

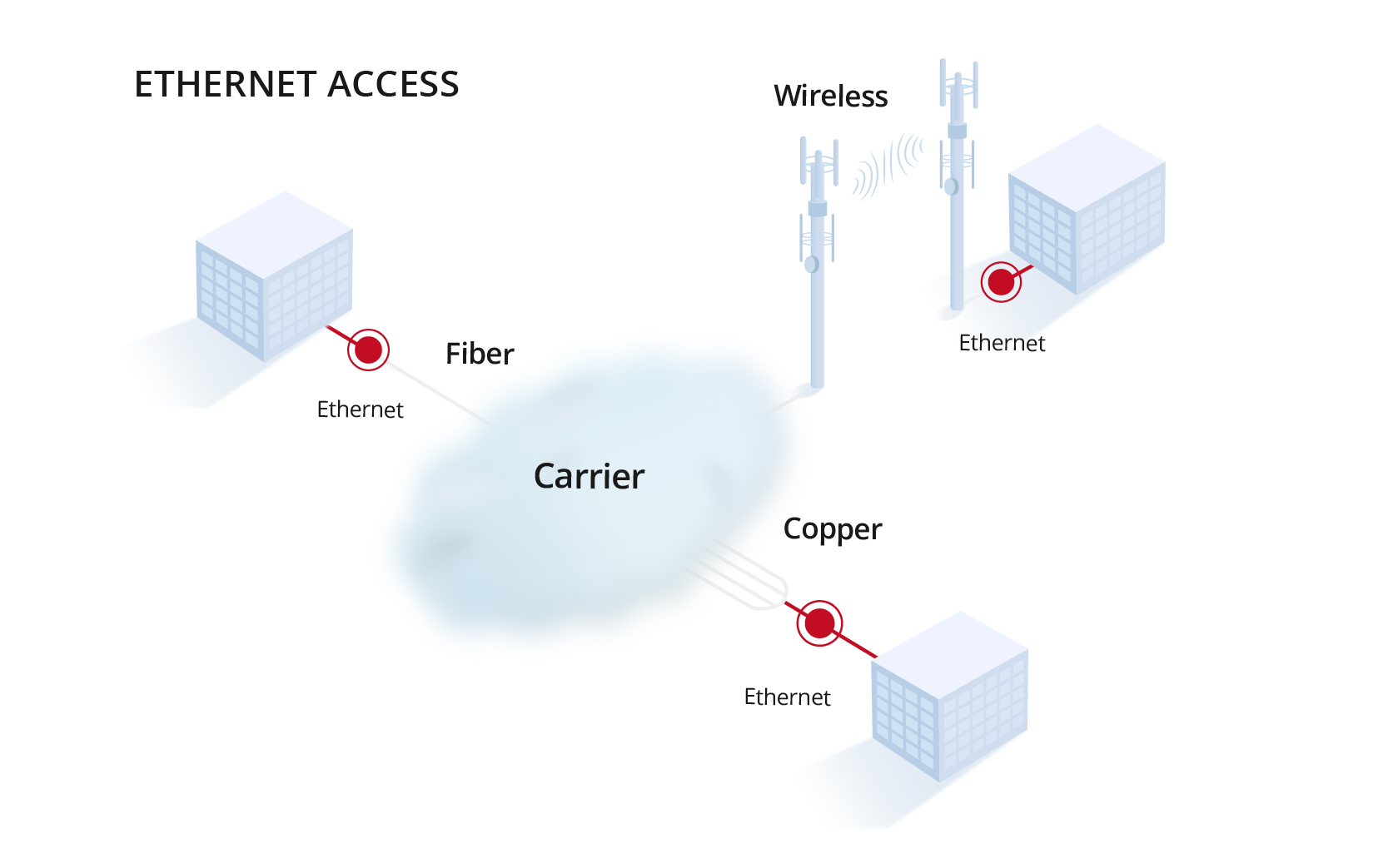

自1980年9月30日引入以来,以太网标准已成为局域网中广泛使用的通信协议。与InfiniBand不同,以太网设计时主要考虑以下几个目标:如何在多个系统之间轻松传输信息?它是一个典型的分布和兼容性设计的网络。传统以太网主要使用TCP/IP构建网络,并逐渐发展为RoCE。

一般来说,以太网网络主要用于将多台计算机或其他设备(如打印机、扫描仪等)连接到局域网。它既可以通过光纤线缆将以太网网络连接到有线网络,也可以通过无线网络技术实现以太网网络在无线网络中的连接。快速以太网、千兆以太网、10千兆以太网和交换式以太网都是主要的以太网类型。

以太网网络

自1980年9月30日引入以来,以太网标准已成为局域网中广泛使用的通信协议。与InfiniBand不同,以太网设计时主要考虑以下几个目标:如何在多个系统之间轻松传输信息?它是一个典型的分布和兼容性设计的网络。传统以太网主要使用TCP/IP构建网络,并逐渐发展为RoCE。

一般来说,以太网网络主要用于将多台计算机或其他设备(如打印机、扫描仪等)连接到局域网。它既可以通过光纤线缆将以太网网络连接到有线网络,也可以通过无线网络技术实现以太网网络在无线网络中的连接。快速以太网、千兆以太网、10千兆以太网和交换式以太网都是主要的以太网类型。

InfiniBand与以太网:它们之间的差异是什么?

高性能计算场景中的集群数据传输瓶颈是InfiniBand的原始设计目标,它已成为符合时代要求的互连标准。因此,InfiniBand和以太网在带宽、延迟、网络可靠性、网络技术和应用场景等方面存在许多差异。

带宽

自InfiniBand问世以来,InfiniBand网络的发展速度一直比以太网更快。主要原因是InfiniBand应用于高性能计算中服务器之间的互连,并减轻CPU负载。然而,以太网更多地面向终端设备互连,对带宽的需求不是太高。

对于超过10G的高速网络流量,如果所有数据包都要解包,将消耗大量资源。第一代SDR InfiniBand的运行速率为10Gbps,除了增加数据传输带宽和减少CPU负载外,还允许高速网络传输以卸载CPU和增加网络利用率。

网络延迟

在网络延迟方面,InfiniBand和以太网的表现也非常不同。以太网交换机通常采用存储-转发和MAC表查找寻址作为网络传输模型中的第二层技术。而以太网交换机的处理流程必须考虑如IP、MPLS和QinQ等复杂服务,耗费时间较长。

另一方面,对于InfiniBand交换机来说,第二层处理非常简单。只有16位的LID可以用来搜索转发路径信息。同时,利用Cut-Through技术并行处理,将转发延迟显著缩短至小于100ns,明显快于以太网交换机。

网络可靠性

由于数据包丢失和重传影响高性能计算的整体性能,需要一个高度可靠的网络协议来确保网络在机制层面上无丢包,并实现其高可靠性。InfiniBand通过自定义的第一层到第四层格式,构建了一个完整的网络协议。端到端的流量控制是InfiniBand网络数据包发送和接收的基础,可以实现无丢包的网络。

与InfiniBand相比,以太网网络没有基于调度的流量控制机制。因此,在发送数据包时无法保证对端是否会出现拥塞。为了能够吸收网络中突发的瞬时流量增加,需要在交换机中开辟数十MB的缓存空间来临时存储这些消息,这将占用芯片资源。这意味着具有相同规格的以太网交换机的芯片面积显著大于InfiniBand芯片,不仅成本更高,而且消耗更多功率。

网络模式

在网络模式方面,InfiniBand网络比以太网网络更容易管理。SDN的逻辑已经在InfiniBand中设计实现。每个InfiniBand第二层网络上都会有一个子网管理器,用于配置网络节点的ID,通过控制平面统一计算转发路径信息,并将其发放给InfiniBand交换机。为了完成网络配置,这样的第二层网络必须在没有任何配置的情况下进行配置。

以太网网络使用自动生成MAC表的网络模式,IP必须与ARP协议配合使用。此外,网络中的每个服务器必须定期发送数据包以确保条目实时更新。为了划分虚拟网络并限制其规模,必须实现VLAN机制。然而,由于以太网网络本身缺乏条目学习机制,会导致环路网络。避免网络转发路径中出现环路,必须实现STP等协议,这增加了网络配置复杂性。

InfiniBand与以太网:它们之间的差异是什么?

高性能计算场景中的集群数据传输瓶颈是InfiniBand的原始设计目标,它已成为符合时代要求的互连标准。因此,InfiniBand和以太网在带宽、延迟、网络可靠性、网络技术和应用场景等方面存在许多差异。

带宽

自InfiniBand问世以来,InfiniBand网络的发展速度一直比以太网更快。主要原因是InfiniBand应用于高性能计算中服务器之间的互连,并减轻CPU负载。然而,以太网更多地面向终端设备互连,对带宽的需求不是太高。

对于超过10G的高速网络流量,如果所有数据包都要解包,将消耗大量资源。第一代SDR InfiniBand的运行速率为10Gbps,除了增加数据传输带宽和减少CPU负载外,还允许高速网络传输以卸载CPU和增加网络利用率。

网络延迟

在网络延迟方面,InfiniBand和以太网的表现也非常不同。以太网交换机通常采用存储-转发和MAC表查找寻址作为网络传输模型中的第二层技术。而以太网交换机的处理流程必须考虑如IP、MPLS和QinQ等复杂服务,耗费时间较长。

另一方面,对于InfiniBand交换机来说,第二层处理非常简单。只有16位的LID可以用来搜索转发路径信息。同时,利用Cut-Through技术并行处理,将转发延迟显著缩短至小于100ns,明显快于以太网交换机。

网络可靠性

由于数据包丢失和重传影响高性能计算的整体性能,需要一个高度可靠的网络协议来确保网络在机制层面上无丢包,并实现其高可靠性。InfiniBand通过自定义的第一层到第四层格式,构建了一个完整的网络协议。端到端的流量控制是InfiniBand网络数据包发送和接收的基础,可以实现无丢包的网络。

与InfiniBand相比,以太网网络没有基于调度的流量控制机制。因此,在发送数据包时无法保证对端是否会出现拥塞。为了能够吸收网络中突发的瞬时流量增加,需要在交换机中开辟数十MB的缓存空间来临时存储这些消息,这将占用芯片资源。这意味着具有相同规格的以太网交换机的芯片面积显著大于InfiniBand芯片,不仅成本更高,而且消耗更多功率。

网络模式

在网络模式方面,InfiniBand网络比以太网网络更容易管理。SDN的逻辑已经在InfiniBand中设计实现。每个InfiniBand第二层网络上都会有一个子网管理器,用于配置网络节点的ID,通过控制平面统一计算转发路径信息,并将其发放给InfiniBand交换机。为了完成网络配置,这样的第二层网络必须在没有任何配置的情况下进行配置。

以太网网络使用自动生成MAC表的网络模式,IP必须与ARP协议配合使用。此外,网络中的每个服务器必须定期发送数据包以确保条目实时更新。为了划分虚拟网络并限制其规模,必须实现VLAN机制。然而,由于以太网网络本身缺乏条目学习机制,会导致环路网络。避免网络转发路径中出现环路,必须实现STP等协议,这增加了网络配置复杂性。

应用场景

由于其高带宽、低延迟和对并行计算的优化支持,InfiniBand在高性能计算(HPC)环境中被广泛应用。它专为处理HPC集群通信需求而设计,其中大规模数据处理和频繁的节点间通信至关重要。而以太网则常用于企业网络、互联网接入和家庭网络,其主要优势是低成本、标准化和广泛支持。

近年来,对大规模计算能力的需求激增,推动了机器内部的高速通信以及超大规模集群中机器间低延迟、高带宽的通信需求。根据Top500超级计算中心的用户统计数据,IB网络在前10和前100个中心中发挥着关键作用。例如,OpenAI利用在Microsoft Azure中构建的IB网络训练ChatGPT,大幅增加了对大型超级计算中心的需求。

选择合适的InfiniBand产品

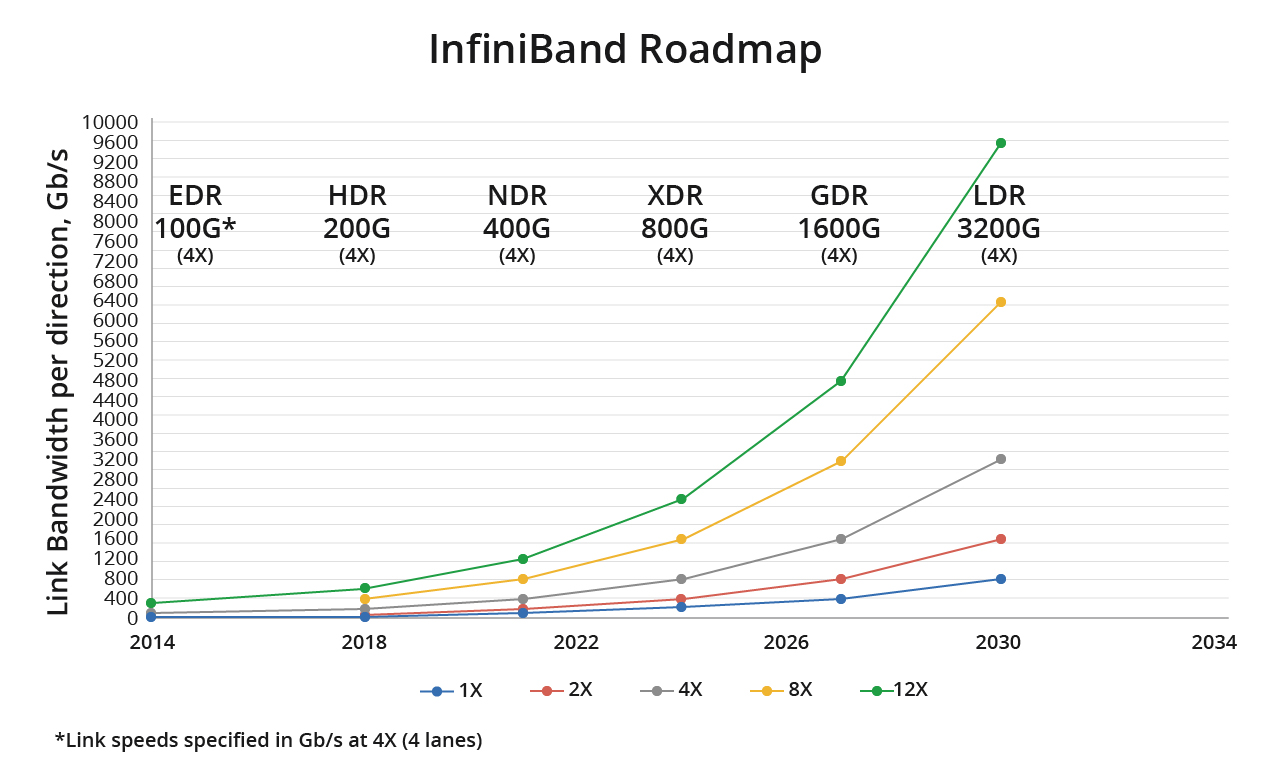

从上述InfiniBand和以太网的比较来看,InfiniBand网络的优势非常突出。InfiniBand网络的快速迭代,从SDR 10Gbps、DDR 20Gbps、QDR 40Gps、FDR 56Gbps、EDR 100Gbps到如今的800Gbps InfiniBand,都得益于RDMA技术。

飞速(FS)推出众多InfiniBand产品,包括InfiniBand光模块&高速线缆、InfiniBand网卡和InfiniBand交换机。

InfiniBand光模块&高速线缆

飞速(FS)提供丰富的40G-200G InfiniBand光模块&高速线缆,以提升计算和存储基础设施的高效互连。

应用场景

由于其高带宽、低延迟和对并行计算的优化支持,InfiniBand在高性能计算(HPC)环境中被广泛应用。它专为处理HPC集群通信需求而设计,其中大规模数据处理和频繁的节点间通信至关重要。而以太网则常用于企业网络、互联网接入和家庭网络,其主要优势是低成本、标准化和广泛支持。

近年来,对大规模计算能力的需求激增,推动了机器内部的高速通信以及超大规模集群中机器间低延迟、高带宽的通信需求。根据Top500超级计算中心的用户统计数据,IB网络在前10和前100个中心中发挥着关键作用。例如,OpenAI利用在Microsoft Azure中构建的IB网络训练ChatGPT,大幅增加了对大型超级计算中心的需求。

选择合适的InfiniBand产品

从上述InfiniBand和以太网的比较来看,InfiniBand网络的优势非常突出。InfiniBand网络的快速迭代,从SDR 10Gbps、DDR 20Gbps、QDR 40Gps、FDR 56Gbps、EDR 100Gbps到如今的800Gbps InfiniBand,都得益于RDMA技术。

飞速(FS)推出众多InfiniBand产品,包括InfiniBand光模块&高速线缆、InfiniBand网卡和InfiniBand交换机。

InfiniBand光模块&高速线缆

飞速(FS)提供丰富的40G-200G InfiniBand光模块&高速线缆,以提升计算和存储基础设施的高效互连。

| 产品类型 | 产品 | 应用 | 连接器 |

| InfiniBand光模块 | 40G光模块 | InfiniBand FDR10 | MTP/MPO-12 |

| 100G光模块 | InfiniBand EDR | 双工LC | |

| 200G光模块 | InfiniBand HDR | MTP/MPO-12 | |

| 400G光模块 | InfiniBand NDR | MTP/MPO-12 APC | |

| 800G光模块 | InfiniBand NDR | 双MTP/MPO-12 APC | |

| InfiniBand高速线缆 | 40G高速线缆 | InfiniBand FDR10 | 双QSFP+到QSFP+ |

| 56G高速线缆 | InfiniBand FDR | 双MTP/MPO-12 APC | |

| 100G高速线缆 | InfiniBand EDR | QSFP28到QSFP28 | |

| 200G高速线缆 | InfiniBand HDR | QSFP56到QSFP56; QSFP56到2 QSFP56 | |

| 400G高速线缆 | InfiniBand HDR | OSFP到2x QSFP56 | |

| 800G高速线缆 | InfiniBand NDR | OSFP到OSFP; OSFP到2× OSFP; OSFP到4× OSFP | |

| InfiniBand有源光缆 | 40G有源光缆 | InfiniBand FDR10 | QSFP+到QSFP+ |

| 56G有源光缆 | InfiniBand FDR | QSFP+到QSFP+ | |

| 100G有源光缆 | InfiniBand EDR | QSFP28到QSFP28 | |

| 200G有源光缆 | InfiniBand HDR | QSFP56到QSFP56; QSFP56到2x QSFP56; 2x QSFP56到2x QSFP56 | |

| 400G有源光缆 | InfiniBand HDR | OSFP到2× QSFP56 |

| 产品 | 速率 | 主机接口 | 端口 |

| MCX653105A-ECAT-SP | HDR和100Gb/s | PCIe 4.0x16 | 单端口 |

| MCX653106A-HDAT-SP | HDR和200Gb/s | PCIe 4.0x16 | 双端口 |

| MCX653106A-ECAT-SP | HDR和100Gb/s | PCIe 4.0x16 | 双端口 |

| MCX653105A-HDAT-SP | HDR和200Gb/s | PCIe 4.0x16 | 单端口 |

| MCX75510AAS-NEAT | NDR和400Gb/s | PCIe 5.0x16 | 单端口 |

| 产品 | MQM8700-HS2F | MQM8790-HS2F | MQM9700-NS2F |

| 产品类型 | 40 x HDR QSFP56 | 40 x HDR QSFP56 | 64 x NDR 400G |

| 功能 | 管理型交换机 | 非管理型交换机 | 管理型交换机 |

| 软件 | MLNX-OS | MLNX-OS | MLNX-OS |

| 交流电源 | 1+1热插拔 | 1+1热插拔 | 1+1热插拔 |

| 风扇数量 | N+1热插拔 | N+1热插拔 | 6+1热插拔 |

| 风向 | 后-前 | 后-前 | 后-前(P2C) |

汇鑫科服隶属于北京通忆汇鑫科技有限公司, 成立于2007年,是一家互联网+、物联网、人工智能、大数据技术应用公司,专注于楼宇提供智能化产品与服务。致力服务写字楼内发展中的中小企业 ,2009年首创楼宇通信BOO模式,以驻地网运营模式为楼宇提供配套运营服务;汇鑫科服始终以客户管理效率为导向,一站式 ICT服务平台,提升写字楼办公场景的办公效率和体验;

汇鑫科服隶属于北京通忆汇鑫科技有限公司, 成立于2007年,是一家互联网+、物联网、人工智能、大数据技术应用公司,专注于楼宇提供智能化产品与服务。致力服务写字楼内发展中的中小企业 ,2009年首创楼宇通信BOO模式,以驻地网运营模式为楼宇提供配套运营服务;汇鑫科服始终以客户管理效率为导向,一站式 ICT服务平台,提升写字楼办公场景的办公效率和体验;